Son los LLM hasta el final - Parte 1

El momento más emocionante para explorar una tecnología es cuando está evolucionando rápidamente

👉 Los modelos más pequeños son cada vez más inteligentes

👉 Más estandarización en todas partes

👉 Las empresas muestran interés en incorporar LLMs

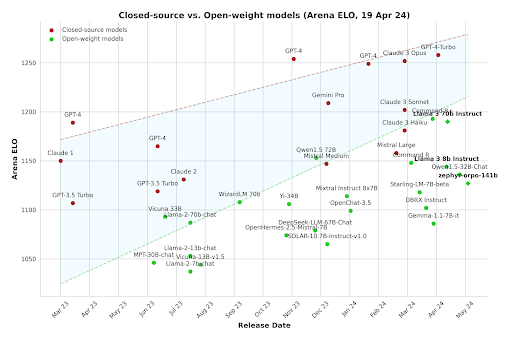

👉 El código abierto se está poniendo al día

Descargo de responsabilidad: Algunas de las declaraciones hechas en esta publicación son pronósticos basados en la información disponible actualmente. Podrían quedar obsoletas en el futuro o podría producirse un cambio importante en el trabajo y las experiencias de estas tecnologías.

Introducción

Los avances recientes en los LLM (modelos de grandes lenguajes), la generación de imágenes y la multimodalidad abren las puertas a todo tipo de aplicaciones. Con los nuevos desarrollos que aparecen a diario, no basta con saber dónde estamos; debemos saber hacia dónde nos dirigimos. Sí, necesitamos predecir el futuro. ¿Por qué intentar algo así? Ahora, además de hacerlo porque es genial, también hay una razón práctica y tangible: la ventaja del primero en moverse es real y poderosa. Poder participar en un nicho o sector a medida que se está formando mientras la competencia es baja es algo muy deseable y te da una ventaja para mejorar. Basta con echar un vistazo. He aquí un ejemplo:

- Cara abrazada comenzó a trabajar con el procesamiento del lenguaje natural alrededor de 2016 antes de dedicarse a ofrecer una variedad de soluciones de inteligencia artificial y aprendizaje automático mucho antes de que los LLM triunfaran. En aquel entonces, los modelos lingüísticos eran más pequeños y manejables, pero más tontos y tenían capacidades limitadas. Hoy en día, HuggingFace se ha convertido en uno de los principales actores de la IA y tiene una valoración de 4.500 millones de dólares.

Por supuesto, no se trata solo de llegar temprano. Necesitas la experiencia técnica y los recursos para lograrlo y, obviamente, un poco de suerte no viene mal.

Predecir el futuro es un desafío, pero podemos hacer conjeturas fundamentadas observando las tendencias actuales.

Empecemos por evaluar el panorama actual.

Mirando a tu alrededor

Los grandes jugadores mueven sus piezas y hacen sus apuestas. Esto puede tomarse como un indicador de la dirección hacia la que nos dirigimos.

Al igual que con los cambios tecnológicos anteriores, vemos un proceso similar al Radiación evolutiva en el que una especie evoluciona para ocupar una multitud de nichos disponibles. Eso es lo que vemos en el enorme esfuerzo que se dedica a las LLM, tanto desde las aplicaciones para el usuario final como el hardware optimizado para la IA.

Los modelos más pequeños son cada vez más inteligentes

En los últimos años, la tendencia ha sido construir LLM cada vez más grandes. Si bien esto continúa, también hay un impulso para fabricar modelos más pequeños y eficientes. ¿Por qué? ¡Porque estas cosas consumen mucho hardware! Esto implica altos costos de infraestructura y límites para las aplicaciones, como la ejecución de la IA en los dispositivos de los usuarios, como los teléfonos, o incluso de forma local en los navegadores web.

Hay una variedad de trucos como: - Ponderaciones del modelo de cuantificación - Intercambio dinámico de LORAs especializados - Modelo de destilación - Programas de formación especializados con conjuntos de datos seleccionados - Pesas de poda

... entre muchos otros, investigó activamente para lograr este objetivo. Los modelos diminutos muy especializados también están obteniendo buenos resultados.

Algunos ejemplos de todos estos esfuerzos son (los nombres no importan tanto, ya que en muy poco tiempo también serán derrotados): - Llama 3 (parámetros 70b) está superando al original Chat GPT 3.5(175b). ¡Reducción de x2,5! - Codificador SQL (7b), un modelo (relativamente) pequeño para la creación de consultas SQL. El rendimiento es comparable al de la GPT4 (aproximadamente 1,8 billones de parámetros). ¡257 veces más pequeña! - PHI-3-pequeño (7 B) está superando a ChatGPT3.5 en algunos puntos de referencia. ¡x75 más pequeño! - Visión PHI-3 (4,2 B) funciona comparativamente bien con modelos de visión mucho más grandes, como el GPT-4V (~1,8 t). ¡Disminución de x428!

Por lo tanto, tenemos una gran cantidad de modelos abiertos que funcionan bien y no son tan grandes. Ajustarlos para una tarea en particular puede conducir a resultados excelentes. Según los resultados y las investigaciones actuales, hay muchas razones para creer que los LLM actuales están muy por debajo de sus capacidades informáticas respectivas. Es decir, si se cuenta con un LLM con, digamos, 20 mil millones de parámetros, los LLM futuros serán capaces de hacer mucho más y serán menos propensos a cometer errores.

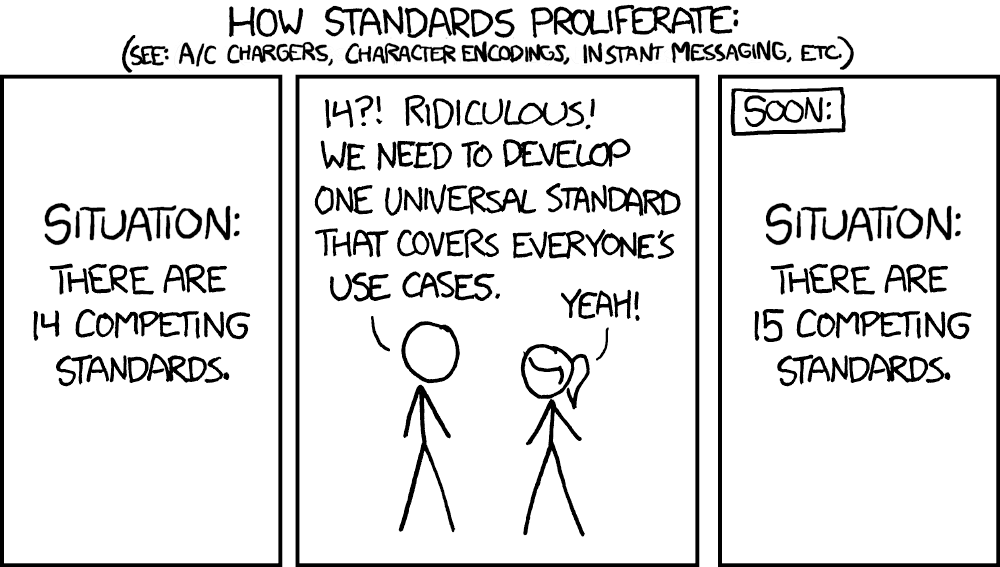

Más estandarización en todas partes

El ecosistema en torno a los LLM está madurando. Las cosas están pasando de crear diseños personalizados a base de pruebas de concepto a sistemas estandarizados listos para la producción. Implementar cosas sin dejar de ser seguro y escalable es cada vez más fácil.

Tomemos, por ejemplo, lecho rocoso amazónico, La solución de IA de generación 1 de AWS. Ofrece puntos de conexión de API para realizar inferencias sobre un conjunto de modelos de generación de imágenes y LLM. Es Sin servidor/SaaS, lo que significa que no tiene que preocuparse por las configuraciones de producción caseras, que son costosas y complejas.

Sin embargo, si necesita una configuración más personalizada, la dirección del servidor también se está estandarizando más. Ejemplificado por NVIDIA NIM. Es una forma optimizada para la inferencia de escalar las aplicaciones de IA en su propia infraestructura. Huggingface tiene recientemente facilitó la implementación de modelos con NIM.

Esto significa que cada día es más fácil utilizar tanto los modelos estándar como los personalizados.

Cada vez hay más modelos competitivos de gran tamaño disponibles, así que, sea cual sea la dirección que tomes, tienes opciones. La propia Nvidia ha publicado recientemente Nemotron-4-340B-Instruct. Un LLM muy, muy grande.

La madurez del ecosistema LLM se destaca por Especificaciones del modelo, que describe las funcionalidades, las métricas de rendimiento y las medidas de seguridad necesarias para implementar modelos lingüísticos de gran tamaño. Esta estandarización mejora la compatibilidad, acelera la innovación y reduce el tiempo de comercialización de las soluciones de IA, lo que facilita la adopción y el escalamiento para las organizaciones.

Los LLM son la nueva UI/UX

Apple ha estado trabajando recientemente en la integración de los LLM con sus teléfonos (ref.1ref2). La premisa básica es que la IA podrá realizar acciones en tu nombre basándose en las instrucciones del usuario en lenguaje natural, con la esperanza de cumplir la promesa de un asistente virtual realmente útil.

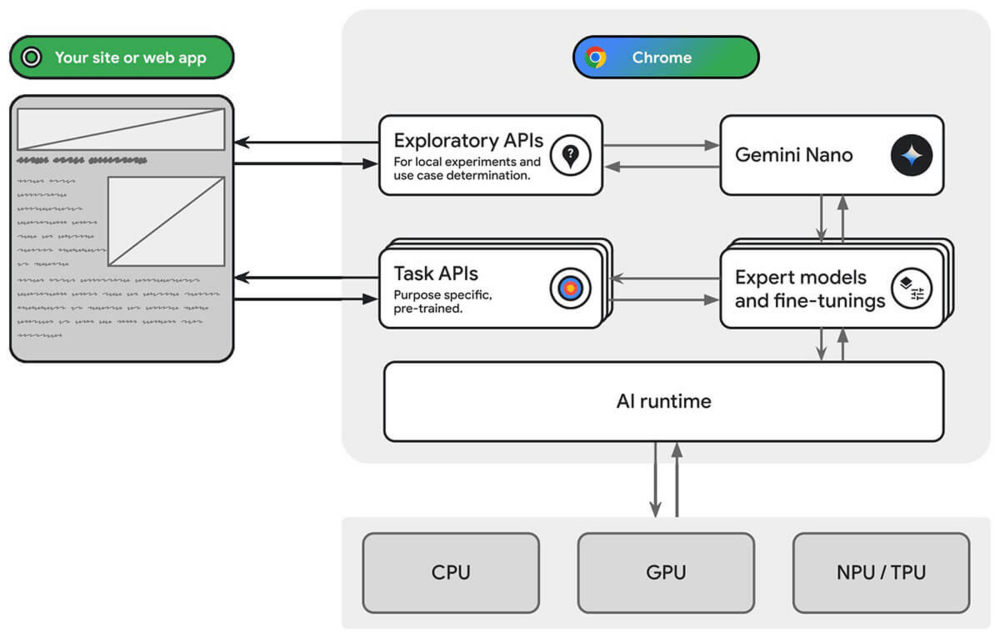

De forma similar, Google Chrome está jugando con la incorporación de Gemini en tu navegación diaria (ref.1ref2).

De Microsoft Copiloto+PC es un destacado. Su nueva función Recall captura continuamente tu actividad, lo que facilita volver a visitar documentos o sitios web describiendo lo que estabas haciendo. Phi-3-Sílice, de los modelos pequeños que analizamos, se integrarán en Copilot+PC, lo que demuestra que ya están avanzando en esta dirección a nivel local. Tenga en cuenta que esta función no estaba exenta de crítica por motivos de seguridad y privacidad.

Innumerables empresas, junto con los principales actores, están integrando la IA en sus productos para mejorar la UI/UX. El compañero de IA de Zoom es un excelente ejemplo de cómo aprovechar los LLM para su modelo de negocio. Ayuda con una variedad de tareas en la plataforma Zoom. Slack y Haga clic arriba están haciendo lo mismo para atraer a más usuarios y ofrecer niveles de precios más altos.

Las empresas muestran interés en incorporar LLMs

Más allá de la perspectiva de UI/UX, las empresas muestran interés en los LLM por varias razones. Si bien no falta publicidad, los LLM están abordando puntos problemáticos reales. Estas incluyen resumir los comentarios de los usuarios, generar anuncios, examinar de forma inteligente grandes documentos, enseñar, ayudar en las tareas de análisis, programar, reducir los costos del servicio de atención al cliente, etc.

Con una gama tan amplia de aplicaciones, está surgiendo un aumento de empresas que intentan superar esos puntos débiles en diferentes mercados. Además, las empresas más tradicionales están empezando a incorporar estas herramientas para mejorar la productividad de sus trabajadores. Sin mencionar que las propias personas se esfuerzan por utilizar los LLM para facilitar su trabajo.

- Filevine está utilizando los LLM para ayudar a los abogados a ser más productivos. Extraer información de documentos, hacer borradores, etc. (árbitro).

- AWS está a día de hoy previsualizando Estudio de aplicaciones de AWS que «utiliza el lenguaje natural para crear aplicaciones de nivel empresarial». En resumen, una herramienta con poco código que utiliza LLMs. También ofrecen un poderoso asistente de inteligencia artificial para varias tareas llamadas Amazon Q.

- Copiloto de GitHub, lanzado en 2021, es ahora una herramienta consolidada que ayuda a los desarrolladores a programar más rápido. Actualmente utiliza llamadas a la API GPT-4.

El código abierto se está poniendo al día

Síguenos en LinkedIn para ver la segunda parte de este blog, donde os contaremos lo que viene en el futuro.

Perspectivas más recientes

.svg)

.webp)