Por qué debería adoptar gestores de flujo de trabajo modernos como Apache Airflow

¿Se está alejando de los planificadores de flujo de trabajo tradicionales?

Muchos equipos siguen confiando en las soluciones de gestión del flujo de trabajo heredadas. Es hora de considerar una actualización. Una de las herramientas modernas de orquestación de flujos de trabajo más potentes y ampliamente adoptadas es Apache Airflow.

Este es solo uno de los muchos tipos de proyectos de ingeniería de datos en la industria y las prácticas de ingeniería de software. Por eso, comprender los conceptos básicos de Apache Airflow es vital para cualquier proyecto de ingeniería de datos que implique la automatización y la migración del flujo de trabajo. También existe la certificación de creación del DAG, que es ideal para quienes necesitan aprender los conceptos básicos de Airflow. Un buen conocimiento de la programación de Airflow y también de la configuración de los DAG, las tareas y la administración de las dependencias entre tareas y DAG.

En Mutt Data, tenemos una amplia experiencia en la implementación Flujo de aire Apache soluciones en varios sectores.

¿Por qué son problemáticos los sistemas de flujo de trabajo heredados?

En primer lugar, definamos un sistema de flujo de trabajo heredado como una aplicación o plataforma de software anticuada que las organizaciones han utilizado para gestionar y automatizar los procesos empresariales, pero que puede que ya no cumpla con los estándares tecnológicos o los requisitos empresariales actuales. Estos sistemas suelen seguir funcionando debido al papel fundamental que desempeñan en las operaciones diarias, al elevado coste de su sustitución o a la complejidad que implica la migración a soluciones más nuevas. Algunos de los programadores antiguos más conocidos son: Control-M, JAMS, Pentaho, Argo, Automic, Data Stage, Oozie, Informatica, etc. Los sistemas de flujo de trabajo tradicionales suelen traer consigo importantes desafíos. Los desafíos comienzan con la duplicación de los flujos de trabajo y los componentes, lo que los hace menos eficientes. Además, hay menos visibilidad y las herramientas antiguas no proporcionan una supervisión óptima, lo que dificulta el seguimiento de los trabajos fallidos o la comprensión de las dependencias.

Algunos otros problemas que se derivan del uso de sistemas de flujo de trabajo heredados son: - Escalabilidad limitada: Los flujos de trabajo tradicionales basados en cron tienen dificultades con el procesamiento de datos a gran escala y la ejecución dinámica de trabajos. - Gestión de dependencias: Los programadores tradicionales requieren mucho trabajo en relación con las configuraciones para administrar las dependencias entre los trabajos y los sistemas. - Extensibilidad mínima: Muchas herramientas antiguas no se pueden integrar fácilmente con los servicios en la nube, las plataformas de datos y las API modernas. - Altos costos de licencia: Los sistemas heredados suelen requerir licencias e infraestructuras costosas, lo que hace que su mantenimiento sea costoso en comparación con las alternativas de código abierto como Airflow. - Mal manejo y registro de errores: La depuración de problemas en los sistemas antiguos es difícil y, a menudo, requiere examinar varios archivos de registro repartidos por los servidores.

Apache Airflow incorpora componentes reutilizables, una práctica recomendada para la ingeniería de software, que mejora la eficiencia y reduce el trabajo redundante. Además, con el código abierto de Airflow, los equipos tienen acceso total al código fuente, lo que proporciona un mayor control y la capacidad de personalizar los flujos de trabajo según las necesidades específicas de la organización.

La transición a Apache Airflow (o a un administrador de flujo de trabajo moderno similar) puede transformar la forma en que se organizan los flujos de trabajo. Los propios astrónomos tienen un repositorio de código abierto donde puedes obtener una demostración rápida de una traducción pública con Orbiter.

¿Por qué deberías usar Apache Airflow para gestionar tus flujos de trabajo?

Apache Airflow es una plataforma de gestión de flujos de trabajo de código abierto diseñada para crear, programar y supervisar los flujos de trabajo mediante programación.

He aquí por qué se ha convertido en la herramienta de referencia para los ingenieros de datos:

1. Sólido apoyo comunitario y empresarial

Apache Airflow cuenta con una sólida comunidad de código abierto que mejora continuamente la plataforma con nuevas funciones y mejoras. Además, cuenta con herramientas como Cosmos, Starship y DAG-Factory, entre otras, para agilizar la organización del flujo de trabajo y mejorar las capacidades de Airflow:

- Cosmos — Un marco para administrar y ejecutar fácilmente modelos de dbt como tareas de flujo de aire. Además de su sólida comunidad. Más allá de eso, Cosmos también permite reutilizar los componentes de Airflow, como las conexiones, para ejecutar consultas. Proporciona la flexibilidad necesaria para especificar dónde se ejecutarán los modelos de deuda de forma externa, como en AWS ECS, GCP, Azure u otros servicios en la nube. Esta capacidad admite un enfoque más modular y escalable para la ejecución del flujo de trabajo, lo que garantiza que los equipos puedan aprovechar su infraestructura de nube existente de manera eficiente. En Mutt Data, hemos colaborado en un repositorio que presenta un operador de AWS ECS que permite a Cosmos ejecutar tareas de dbt en AWS ECS. Esto garantiza que las ejecuciones de dbt sean coherentes con los DAG de flujo de aire existentes que se ejecutan en ECS.

- Nave estelar — Una utilidad para migrar los metadatos del flujo de aire, como las variables de flujo de aire, las conexiones, las variables de entorno, los grupos y el historial de DAG entre dos instancias de flujo de aire.

- fábrica de té — Una herramienta de código abierto que simplifica la creación de DAG de forma dinámica.

2. Implementaciones híbridas y nativas de la nube

Airflow se integra perfectamente con los ecosistemas nativos de la nube y se puede implementar en Kubernetes, COMO MAA, Google Cloud Composer, Astrónomo, o configuraciones autogestionadas, que ofrecen flexibilidad para diferentes necesidades de infraestructura.

Astrónomo, como servicio gestionado de Airflow, proporciona una plataforma de nivel empresarial que simplifica la implementación, la supervisión y el escalado, lo que la convierte en una excelente opción para los equipos que buscan una solución totalmente gestionada con soporte profesional.

3. Airflow proporciona herramientas para que todos lo usen y escuche a sus usuarios

Para los equipos que migran de gestores de flujo de trabajo antiguos a Airflow, sus Guía definitiva de DAG puede ayudar a refinar y mejorar la implementación del DAG. Para usuarios sin conocimientos técnicos, herramientas como fábrica de té ofrecen una forma de generar DAG de forma dinámica, lo que facilita la gestión de los flujos de trabajo sin una profunda experiencia en codificación. El aspecto más importante a destacar aquí es que Airflow tiene un ecosistema de código abierto que hace que sea mucho más fácil de integrar con otros sistemas.

Tanto los profesionales como la comunidad han reconocido a Airflow como un excelente servicio. La comunidad habló a través de las reseñas de los repositorios de GitHub. Además, Airflow cuenta con una comunidad dinámica que busca apoyar a los usuarios y desarrolladores, ayudar en el desarrollo de herramientas y enriquecer el uso de Airflow en general. Astronomer forma parte de esa comunidad y desempeña un papel importante cuando se trata de expandirla. Puedes ver un ejemplo en su última encuesta donde el 93% de los 5.250 encuestados afirma que el flujo de aire es importante para su negocio.

¿Por qué nos encanta Apache Airflow en Mutt Data?

Airflow ha estado en el centro de nuestra práctica de consultoría en Mutt Data durante más de 6 años. Nuestra trayectoria ha dado forma a nuestra experiencia en la automatización moderna del flujo de trabajo, tanto es así que hemos desarrollado las mejores prácticas y perfeccionado las metodologías para implementar y optimizar Airflow a escala. Decidimos escribir sobre ello y compartir lo que hemos aprendido: Gestión moderna del flujo de trabajo con Airflow. El resultado de nuestra experiencia es que recomendamos encarecidamente Apache Airflow como herramienta de gestión del flujo de trabajo debido a su flexibilidad, escalabilidad y amplio ecosistema. Es posible que necesite ayuda durante su viaje, por lo que, si está buscando un servicio gestionado con orientación profesional, Astronomer ofrece soporte de Airflow de nivel empresarial para ayudar a los equipos a implementar las mejores prácticas y optimizar la organización de su flujo de trabajo. En Mutt Data, nos encanta Apache Airflow porque permite a nuestros equipos de datos optimizar los flujos de trabajo complejos con facilidad. Su enfoque basado en Python y el sólido apoyo de la comunidad nos permiten adaptar rápidamente los flujos de trabajo para satisfacer las diversas necesidades de los clientes, ya estén en la nube o en servidores privados. Al proporcionar funciones listas para usar, como reintentos automáticos, monitoreo detallado y control de versiones sin interrupciones, Airflow nos ayuda a mantener la confiabilidad y la transparencia. Su escalabilidad garantiza que estemos preparados para las crecientes cargas de trabajo, y su integración con varias plataformas y herramientas lo convierte en una parte esencial de nuestras soluciones de datos. Airflow no solo nos ahorra tiempo, sino que también nos permite ofrecer un mayor valor a nuestros clientes, por lo que confiamos tanto en él en nuestras operaciones. Además, Astronomer desempeña un papel fundamental a la hora de apoyar a la comunidad Apache Airflow, al fomentar un ecosistema dinámico en el que los profesionales de datos puedan conectarse y crecer. Con más de 33 000 miembros en Slack y más de 2500 colaboradores, la comunidad Apache Airflow ofrece una gran cantidad de conocimientos y recursos. Astronomer mejora esta experiencia al ofrecer servicios de flujo de aire gestionados, simplificar la gestión de la infraestructura y ofrecer escalabilidad y elasticidad. Para las organizaciones que buscan una solución más sólida y autogestionada, la plataforma de Astronomer ofrece alta disponibilidad, tolerancia a fallos y soporte dedicado, lo que permite a los equipos centrarse en crear y optimizar los flujos de trabajo de datos sin la sobrecarga operativa.

¿Estás pensando en migrar a Airflow? :

Estos son los recursos a tener en cuenta

Expertos: Mutt Data <> Astrónomo

Mutt Data ayuda a las organizaciones a migrar a Apache Airflow de manera eficiente. Como funcionario socio de Astrónomo, aportamos una amplia experiencia en la organización del flujo de trabajo y ayudamos a los equipos a migrar desde sistemas heredados. Nuestros servicios incluyen la evaluación del flujo de trabajo, la optimización de los DAG, el desarrollo de complementos personalizados y el ajuste del rendimiento, lo que garantiza una transición perfecta y adaptada a las necesidades de su empresa. La migración a Airflow es un paso crucial para muchas organizaciones. Astronomer ha proporcionado varios recursos para guiar a los equipos a través de esta transición, que incluyen: - Webinar: Pasar de Legacy Schedulers a Airflow: el próximo seminario web tendrá lugar el mes que viene y en el que se analizará en profundidad el proceso de migración con Orbiter. - Charla de Airflow Summit sobre Orbiter — Una sesión anterior que abordó cómo Orbiter facilita la migración y las principales lecciones aprendidas.

Una herramienta que cambia las reglas del juego: Orbiter

Supongamos que está pensando en migrar a Airflow y busca una solución más sólida y autogestionada. En ese caso, Orbitador es una opción sobresaliente que proporciona un conjunto completo de funciones para administrar y organizar los flujos de trabajo de datos.

Astronomer también ha desarrollado Orbiter, una herramienta que simplifica el proceso de migración de los planificadores de tareas antiguos a Apache Airflow, lo que garantiza una transición sin problemas con un tiempo de inactividad mínimo.

Las funciones avanzadas de Astro mejoran la productividad del equipo al agilizar la creación, la ejecución y la supervisión de los flujos de trabajo, lo que permite a los equipos de datos centrarse en tareas estratégicas en lugar de en la gestión de la infraestructura. Con una comunidad dinámica de código abierto y el soporte empresarial de empresas como Astronomer, Airflow ofrece la escalabilidad, la fiabilidad y las herramientas necesarias para gestionar de manera eficiente los flujos de trabajo complejos, lo que lo convierte en la mejor opción para la orquestación de datos.

Para los equipos que migran de gestores de flujo de trabajo antiguos a Airflow, Orbitador proporciona una ruta de migración estructurada. Orbiter exporta un código de referencia equivalente a la lógica existente en los sistemas antiguos, lo que proporciona un punto de partida sólido para refinar los flujos de trabajo. Si bien no es una solución perfecta, acelera significativamente el proceso de migración.

Principales beneficios de usar Orbiter para la migración:

- Automatiza la conversión del flujo de trabajo: reduce el esfuerzo manual al exportar los DAG de las programaciones antiguas.

- Garantiza la coherencia lógica: ayuda a mantener las dependencias del flujo de trabajo durante la migración.

- Acelera la adopción: proporciona un punto de partida sólido que puede optimizarse aún más para las mejores prácticas de Airflow.

También hay que hacer hincapié en los precios de Astrónomos. El modelo de precios de Astronomer ofrece una estructura flexible basada en el uso. Este enfoque de pago por uso permite a las organizaciones ampliar sus necesidades de orquestación de datos.

EDITAR: en el momento de escribir este blog, Astrónomo ideó un enfoque de precios aún más flexible que facilitaba el acceso a la plataforma.

Cómo migrar de sistemas antiguos a Airflow

- Configure la red, la infraestructura y la autenticación: establezca la infraestructura básica para implementar Airflow. La utilización de servicios gestionados como Astronomer puede simplificar este proceso, al ofrecer escalabilidad y reducir la sobrecarga operativa. Implemente procesos canarios para verificar las conexiones exitosas entre Airflow y los sistemas externos, garantizando integraciones confiables.

- Identifique patrones comunes: analice los flujos de trabajo existentes para detectar patrones de diseño en los sistemas heredados. Reconozca elementos como las configuraciones de programación y las dependencias de las tareas para crear reglas de traducción equivalentes en Airflow. Por ejemplo, los bloques XYZ pueden definir la programación de tareas y necesitar una regla de traducción para simular el mismo comportamiento. Al mismo tiempo, es necesario saber si algún comando se está ejecutando de forma remota (sshoperator) y ver cuál es la composición de los DAG. También es posible detectar la forma de detectar las dependencias del sistema antiguo y pasarlas al código Airflow.

- Migrar: herramientas como Orbiter automatizan la traducción de los flujos de trabajo antiguos en DAG de flujo de aire. Defina reglas de traducción que relacionen los conceptos de sistemas antiguos con las construcciones de Airflow, lo que facilita un proceso de migración eficiente.

- Traducir: desarrolle reglas para definir los DAG, sus parámetros y tareas, filtrar los elementos que no son de los DAG y personalizar el código migrado.

- Implementación: pruebe el código migrado en un entorno de desarrollo para validar la funcionalidad. La ejecución de los DAG en esta configuración controlada permite identificar y resolver los problemas antes de pasar a la producción.

- Refactorización: aplique las mejores prácticas para mejorar la eficiencia y la capacidad de mantenimiento de los flujos de trabajo. Considere la posibilidad de implementar fábricas de DAG para la generación dinámica de DAG y tareas, parametrizar los DAG para aumentar la flexibilidad y garantizar la idempotencia para garantizar resultados consistentes con los mismos insumos.

Próximamente Airflow v3

Una de las funciones más esperadas de Airflow v3 es «Airflow Tasks Anywhere, in Any Language», que permitirá a los usuarios ejecutar tareas en diferentes lenguajes de programación sin problemas. Esta mejora hará que Airflow sea aún más flexible y accesible para diversas cargas de trabajo, eliminando la necesidad de implementaciones exclusivas de Python. Para mantenerse actualizado sobre los últimos cambios y desarrollos, siga el debate en GitHub.

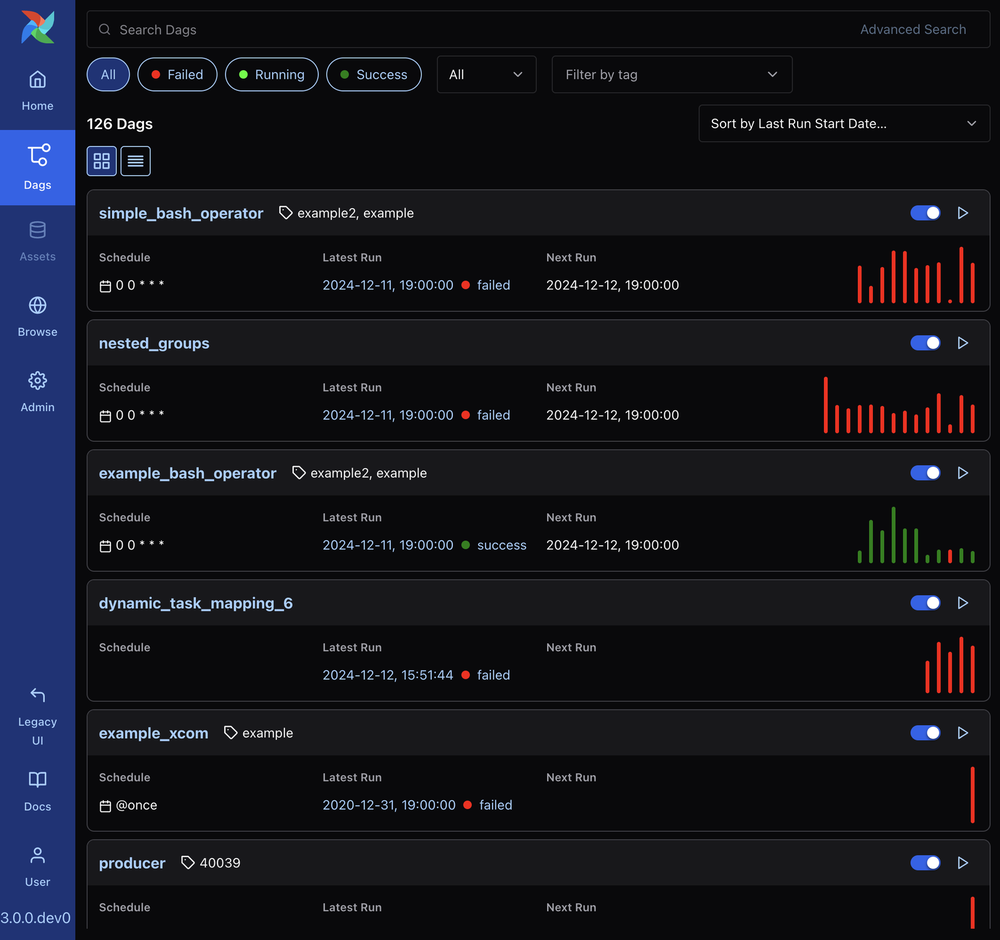

Lanzamiento de Apache Airflow 3.0 mediados de abril de 2025 e introduce mejoras significativas en la organización del flujo de trabajo. La noticia más importante es que Flujo de aire 3) presenta mejoras importantes, como el control de versiones de DAG, una interfaz de usuario modernizada basada en React, una mejor compatibilidad con el relleno y la capacidad de ejecutar tareas en varios lenguajes de programación además de Python, como Go, Java, JavaScript y TypeScript. Si bien los DAG (gráficos acíclicos dirigidos) aún se definen en Python, este soporte multilingüe permite implementar las tareas en el lenguaje que mejor se adapte a las necesidades específicas del proyecto, lo que facilita una integración perfecta con varias API y bibliotecas.

Además, Airflow 3.0 presenta una arquitectura más flexible que permite que las tareas se ejecuten en entornos externos, desacoplándolas del ejecutor principal de la máquina local. Este avance se logra mediante la implementación de la interfaz de ejecución de tareas (AIP-72), lo que facilita la evolución de Airflow hacia una arquitectura cliente-servidor. Este cambio permite realizar despliegues en múltiples nubes y mejorar la escalabilidad, lo que ofrece una mayor flexibilidad y aislamiento de la seguridad para los flujos de trabajo complejos.

Estas mejoras demuestran el compromiso de Airflow de adaptarse a las necesidades cambiantes de los equipos de datos, proporcionando herramientas más sólidas y versátiles para organizar flujos de trabajo complejos.

Conclusión

Migración de sistemas heredados a orquestadores de flujo de trabajo modernos como Apache Airflow cambia las reglas del juego. Proporciona mejoras visibilidad, escalabilidad, capacidad de mantenimiento y extensibilidad, aunque también de manera significativa reducir los costos al eliminar las costosas tarifas de licencia. Además, contando con el asesoramiento de expertos como Datos de Mutt y Astronomer, además de aprovechar las herramientas de Astrónomo, como Cosmos, nave estelar, orbitador, y Fábrica DAG entre otros, pueden agilizar aún más la implementación, la migración y la administración del flujo de trabajo. En particular, Orbitador acelera significativamente el proceso de migración de los programadores antiguos a Apache Airflow, lo que resulta en ahorro sustancial de tiempo. Al automatizar las tareas de traducción complejas, Orbiter mejora la experiencia de los desarrolladores, ya que ofrece un mayor control y una mejor visibilidad durante todo el proceso de migración. Esta eficiencia permite a los equipos realizar una transición más fluida y centrarse en optimizar sus flujos de trabajo dentro de Airflow. ¿Está realizando actualmente la transición de sistemas antiguos a Airflow? ¿Necesita la ayuda de un experto con su migración? Mutt Data puede gestionar todo el proceso de migración por usted, garantizando una transición fluida a Airflow. Póngase en contacto con nosotros a través de nuestro Página de contacto de Mutt Data ¡para saber cómo podemos ayudar!

¿Qué tan fácil es entrar en Airflow? ¿Qué tan eficiente es Orbiter?

Un seminario web para profundizar sus conocimientos sobre el proceso de migración con Orbiter.

El astrónomo sostuvo un seminario web para sumergirse en el proceso de migración con Orbiter. En este seminario web, Astrónomo presenta, Fritz Davenport y Naveen Sukumar le mostrará cómo Airflow le ayuda a entregar flujos de trabajo más rápido, minimizar el tiempo de inactividad y escalar sus operaciones sin esfuerzo.

Es una buena introducción a Orbiter y a la forma en que la herramienta elimina la complejidad de la migración y le permite modernizar sus operaciones de datos con facilidad y aprender cómo Apache Airflow ofrece un rendimiento, una confiabilidad y una personalización mejorados en comparación con los programadores antiguos

También exploraron estudios de casos reales sobre cómo las migraciones son fáciles cuando se realizan en Airflow con Orbiter

Perspectivas más recientes

.svg)

.webp)