Son los LLM hasta el final - Parte 1

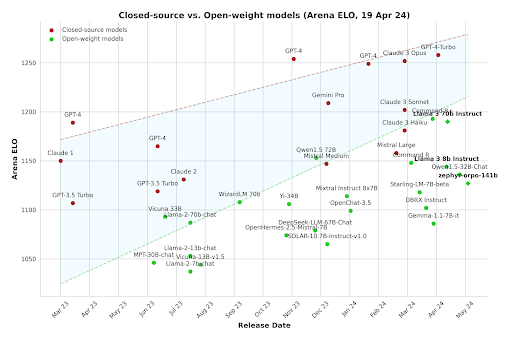

👉 Los modelos más pequeños son cada vez más inteligentes

👉 Más estandarización en todas partes

👉 Las empresas muestran interés en incorporar LLMs

👉 El código abierto se está poniendo al día

Descargo de responsabilidad: Algunas de las declaraciones hechas en esta publicación son pronósticos basados en la información disponible actualmente. Podrían quedar obsoletas en el futuro o podría producirse un cambio importante en el trabajo y las experiencias de estas tecnologías.

Introducción

Los avances recientes en los LLM (modelos de grandes lenguajes), la generación de imágenes y la multimodalidad abren las puertas a todo tipo de aplicaciones. Con los nuevos desarrollos que aparecen a diario, no basta con saber dónde estamos; debemos saber hacia dónde nos dirigimos. Sí, necesitamos predecir el futuro. ¿Por qué intentar algo así? Ahora, además de hacerlo porque es genial, también hay una razón práctica y tangible: la ventaja del primero en moverse es real y poderosa. Poder participar en un nicho o sector a medida que se está formando mientras la competencia es baja es algo muy deseable y te da una ventaja para mejorar. Basta con echar un vistazo. He aquí un ejemplo:

- Cara abrazada comenzó a trabajar con el procesamiento del lenguaje natural alrededor de 2016 antes de dedicarse a ofrecer una variedad de soluciones de inteligencia artificial y aprendizaje automático mucho antes de que los LLM triunfaran. En aquel entonces, los modelos lingüísticos eran más pequeños y manejables, pero más tontos y tenían capacidades limitadas. Hoy en día, HuggingFace se ha convertido en uno de los principales actores de la IA y tiene una valoración de 4.500 millones de dólares.

Por supuesto, no se trata solo de llegar temprano. Necesitas la experiencia técnica y los recursos para lograrlo y, obviamente, un poco de suerte no viene mal.

Predecir el futuro es un desafío, pero podemos hacer conjeturas fundamentadas observando las tendencias actuales.

Empecemos por evaluar el panorama actual.

Mirando a tu alrededor

Los grandes jugadores mueven sus piezas y hacen sus apuestas. Esto puede tomarse como un indicador de la dirección hacia la que nos dirigimos.

Al igual que con los cambios tecnológicos anteriores, vemos un proceso similar al Radiación evolutiva en el que una especie evoluciona para ocupar una multitud de nichos disponibles. Eso es lo que vemos en el enorme esfuerzo que se dedica a las LLM, tanto desde las aplicaciones para el usuario final como el hardware optimizado para la IA.

Los modelos más pequeños son cada vez más inteligentes

En los últimos años, la tendencia ha sido construir LLM cada vez más grandes. Si bien esto continúa, también hay un impulso para fabricar modelos más pequeños y eficientes. ¿Por qué? ¡Porque estas cosas consumen mucho hardware! Esto implica altos costos de infraestructura y límites para las aplicaciones, como la ejecución de la IA en los dispositivos de los usuarios, como los teléfonos, o incluso de forma local en los navegadores web.

Hay una variedad de trucos como: - Ponderaciones del modelo de cuantificación - Intercambio dinámico de LORAs especializados - Modelo de destilación - Programas de formación especializados con conjuntos de datos seleccionados - Pesas de poda

... entre muchos otros, investigó activamente para lograr este objetivo. Los modelos diminutos muy especializados también están obteniendo buenos resultados.

Algunos ejemplos de todos estos esfuerzos son (los nombres no importan tanto, ya que en muy poco tiempo también serán derrotados): - Llama 3 (parámetros 70b) está superando al original Chat GPT 3.5(175b). ¡Reducción de x2,5! - Codificador SQL (7b), un modelo (relativamente) pequeño para la creación de consultas SQL. El rendimiento es comparable al de la GPT4 (aproximadamente 1,8 billones de parámetros). ¡257 veces más pequeña! - PHI-3-pequeño (7 B) está superando a ChatGPT3.5 en algunos puntos de referencia. ¡x75 más pequeño! - Visión PHI-3 (4,2 B) funciona comparativamente bien con modelos de visión mucho más grandes, como el GPT-4V (~1,8 t). ¡Disminución de x428!

Por lo tanto, tenemos una gran cantidad de modelos abiertos que funcionan bien y no son tan grandes. Ajustarlos para una tarea en particular puede conducir a resultados excelentes. Según los resultados y las investigaciones actuales, hay muchas razones para creer que los LLM actuales están muy por debajo de sus capacidades informáticas respectivas. Es decir, si se cuenta con un LLM con, digamos, 20 mil millones de parámetros, los LLM futuros serán capaces de hacer mucho más y serán menos propensos a cometer errores.

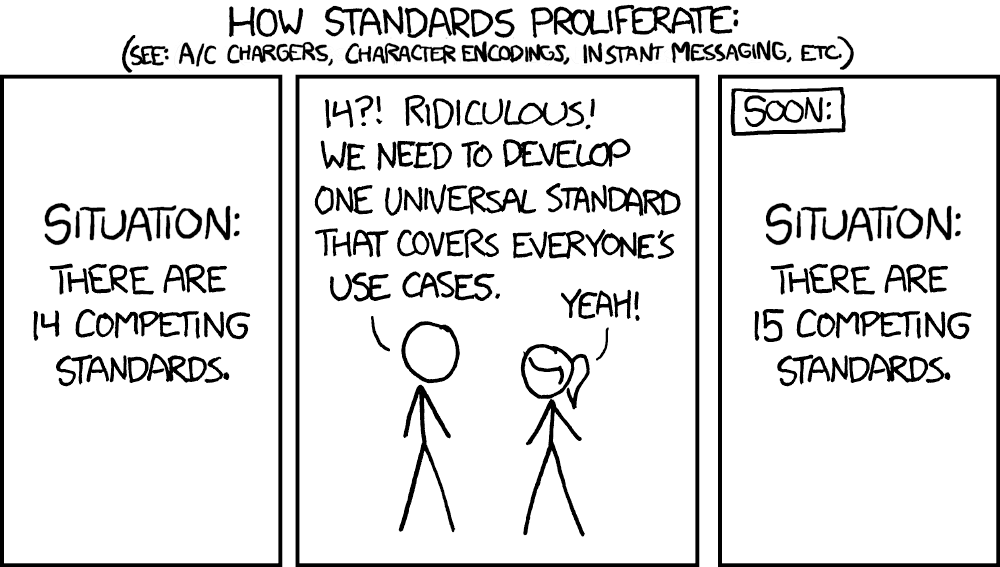

Más estandarización en todas partes

El ecosistema en torno a los LLM está madurando. Las cosas están pasando de crear diseños personalizados a base de pruebas de concepto a sistemas estandarizados listos para la producción. Implementar cosas sin dejar de ser seguro y escalable es cada vez más fácil.

Tomemos, por ejemplo, lecho rocoso amazónico, La solución de IA de generación 1 de AWS. Ofrece puntos de conexión de API para realizar inferencias sobre un conjunto de modelos de generación de imágenes y LLM. Es Sin servidor/SaaS, lo que significa que no tiene que preocuparse por las configuraciones de producción caseras, que son costosas y complejas.

Sin embargo, si necesita una configuración más personalizada, la dirección del servidor también se está estandarizando más. Ejemplificado por NVIDIA NIM. Es una forma optimizada para la inferencia de escalar las aplicaciones de IA en su propia infraestructura. Huggingface tiene recientemente facilitó la implementación de modelos con NIM.

Esto significa que cada día es más fácil utilizar tanto los modelos estándar como los personalizados.

Cada vez hay más modelos competitivos de gran tamaño disponibles, así que, sea cual sea la dirección que tomes, tienes opciones. La propia Nvidia ha publicado recientemente Nemotron-4-340B-Instruct. Un LLM muy, muy grande.

La madurez del ecosistema LLM se destaca por Especificaciones del modelo, que describe las funcionalidades, las métricas de rendimiento y las medidas de seguridad necesarias para implementar modelos lingüísticos de gran tamaño. Esta estandarización mejora la compatibilidad, acelera la innovación y reduce el tiempo de comercialización de las soluciones de IA, lo que facilita la adopción y el escalamiento para las organizaciones.

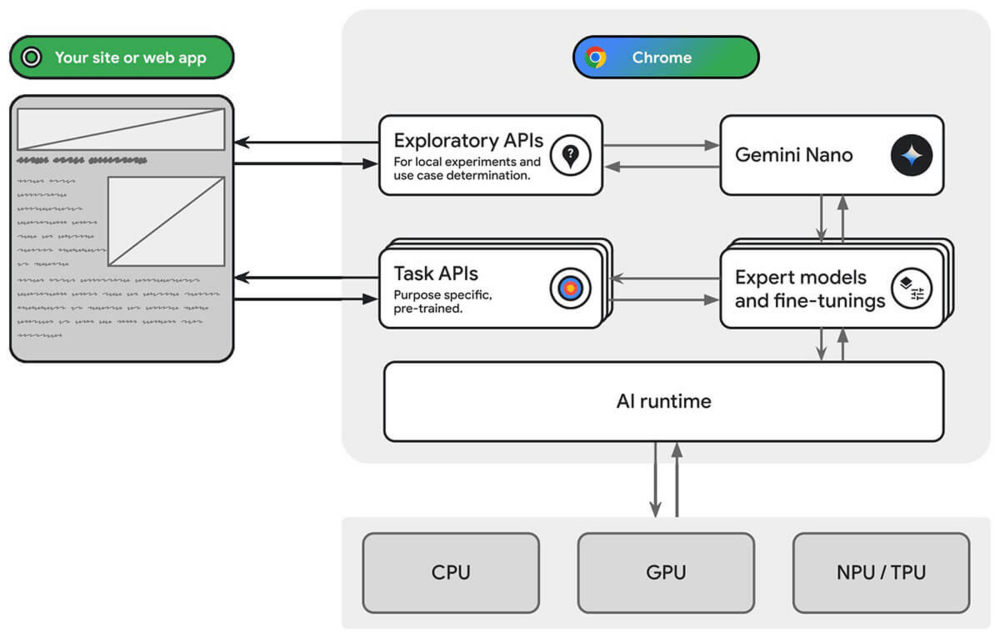

Los LLM son la nueva UI/UX

Apple ha estado trabajando recientemente en la integración de los LLM con sus teléfonos (ref.1ref2). La premisa básica es que la IA podrá realizar acciones en tu nombre basándose en las instrucciones del usuario en lenguaje natural, con la esperanza de cumplir la promesa de un asistente virtual realmente útil.

De forma similar, Google Chrome está jugando con la incorporación de Gemini en tu navegación diaria (ref.1ref2).

De Microsoft Copiloto+PC es un destacado. Su nueva función Recall captura continuamente tu actividad, lo que facilita volver a visitar documentos o sitios web describiendo lo que estabas haciendo. Phi-3-Sílice, de los modelos pequeños que analizamos, se integrarán en Copilot+PC, lo que demuestra que ya están avanzando en esta dirección a nivel local. Tenga en cuenta que esta función no estaba exenta de crítica por motivos de seguridad y privacidad.

Innumerables empresas, junto con los principales actores, están integrando la IA en sus productos para mejorar la UI/UX. El compañero de IA de Zoom es un excelente ejemplo de cómo aprovechar los LLM para su modelo de negocio. Ayuda con una variedad de tareas en la plataforma Zoom. Slack y Haga clic arriba están haciendo lo mismo para atraer a más usuarios y ofrecer niveles de precios más altos.

Las empresas muestran interés en incorporar LLMs

Más allá de la perspectiva de UI/UX, las empresas muestran interés en los LLM por varias razones. Si bien no falta publicidad, los LLM están abordando puntos problemáticos reales. Estas incluyen resumir los comentarios de los usuarios, generar anuncios, examinar de forma inteligente grandes documentos, enseñar, ayudar en las tareas de análisis, programar, reducir los costos del servicio de atención al cliente, etc.

Con una gama tan amplia de aplicaciones, está surgiendo un aumento de empresas que intentan superar esos puntos débiles en diferentes mercados. Además, las empresas más tradicionales están empezando a incorporar estas herramientas para mejorar la productividad de sus trabajadores. Sin mencionar que las propias personas se esfuerzan por utilizar los LLM para facilitar su trabajo.

- Filevine está utilizando los LLM para ayudar a los abogados a ser más productivos. Extraer información de documentos, hacer borradores, etc. (árbitro).

- AWS está a día de hoy previsualizando Estudio de aplicaciones de AWS que «utiliza el lenguaje natural para crear aplicaciones de nivel empresarial». En resumen, una herramienta con poco código que utiliza LLMs. También ofrecen un poderoso asistente de inteligencia artificial para varias tareas llamadas Amazon Q.

- Copiloto de GitHub, lanzado en 2021, es ahora una herramienta consolidada que ayuda a los desarrolladores a programar más rápido. Actualmente utiliza llamadas a la API GPT-4.

El código abierto se está poniendo al día

Síguenos en LinkedIn para ver la segunda parte de este blog, donde os contaremos lo que viene en el futuro.

El camino de Mutt Data hacia la competencia tecnológica de publicidad y marketing de AWS

👉 ¿Qué es AdTech & MarTech? ¿Por qué es importante?

👉 ¿Cuál es la diferencia entre AdTech y MarTech?

👉 Etermax

👉 3 X 3 M

Tenemos una gran noticia: Mutt Data ahora es oficialmente una AWS ¡Socio competente en tecnología de publicidad y marketing! Esta competencia continúa nuestro continuo camino de asociación con AWS, de parte de socios selectos de AWS, especialistas en RDS y socios avanzados de AWS. Ahora hemos sido reconocidos en el campo de la publicidad y el marketing.

Mutt Data se ha convertido en el único socio de AWS en la región SOLA que ha obtenido esta competencia.

Esta competencia valida nuestra experiencia y proyectos exitosos en los campos de AdTech y MarTech. Pero, ¿qué son?

¿Qué es AdTech & MarTech? ¿Por qué es importante?

Somos expertos en la intersección de Tecnología y datos en los campos de Publicidad y marketing. Básicamente, ¡potenciamos la eficiencia en sus acciones de marketing a través de una combinación de datos, tecnología, aprendizaje automático, aprendizaje profundo, redes neuronales y análisis predictivo! Con el poder de los datos, es posible encontrar formas de distribuir de manera eficiente tu inversión en marketing para maximizar los resultados o encontrar a los usuarios que tienen más probabilidades de estar interesados en tu anuncio. Todo esto y mucho más puede automatizarse mediante algoritmos de inteligencia artificial y optimizarse mediante el desarrollo de las capacidades técnicas de un paquete de tecnología publicitaria o tecnológica publicitaria.

¿Cuál es la diferencia entre AdTech y MarTech?

Tecnología publicitaria (Tecnología publicitaria) se centra en las herramientas y el software que se utilizan para gestionar, entregar y analizar las campañas de publicidad digital. Incluye tecnologías como las plataformas del lado de la demanda (DSP), las plataformas del lado de la oferta (SSP), los intercambios de anuncios, las redes publicitarias y las plataformas de administración de datos (DMP). AdTech ayuda a los anunciantes a llegar a su público objetivo, optimizar la inversión publicitaria y medir la eficacia de sus campañas. También incluye tecnología relacionada con la creación, el funcionamiento y la optimización de redes de medios minoristas y administradores de anuncios.

MarTech (Tecnología de marketing) abarca las herramientas y el software que se utilizan para planificar, ejecutar y medir las campañas de marketing en varios canales. Esto incluye los sistemas de gestión de relaciones con los clientes (CRM), las plataformas de marketing por correo electrónico, las herramientas de gestión de redes sociales, los sistemas de gestión de contenido (CMS) y las plataformas de automatización del marketing. MarTech permite a los profesionales del marketing crear experiencias personalizadas para los clientes, realizar un seguimiento del compromiso y optimizar los esfuerzos de marketing.

Adtech y Martech son dos caras de la misma moneda. Cada uno desempeña un papel fundamental en el ecosistema publicitario. Mientras que la tecnología publicitaria abarca tecnologías que ayudan a vender anuncios, se centran en la entrega y la medición de las campañas publicitarias. MarTech, por otro lado, agrupa tecnologías que ayudan a comprar anuncios, gestionar y analizar las iniciativas de marketing para optimizar la participación de los consumidores y las ventas.

Tenemos experiencia en la realización de tareas técnicas como:

Tecnología publicitaria

✅ Investigación, diseño y desarrollo de nuevos mecanismos de subasta, fijación de precios y ritmo. Mediante ofertas en tiempo real (RTB), una plataforma del lado de la demanda (DSP) y una plataforma del lado de la oferta (SSP).

✅ Desarrollo de soluciones para precios dinámicos, optimización basada en costos, optimización basada en relevancia y ofertas automatizadas.

✅ Entrenamiento de modelos de aprendizaje automático para predecir la tasa de ganancia, el costo, el CTR, el CVR y el CVR_VTA. Implementación de modelos de bandidos con varios brazos para la optimización creativa.

✅ Construir un ritmo y una modulación de precios basados en el rendimiento.

✅ Arquitecturas de transmisión de eventos que combinan Kafka y Druid/Pinot o Kinesis con S3.

✅ Lagos de datos eficientes que combinan AWS EMR con los formatos Presto/Trino, AWS Athena, AWS Glue o Delta Lake.

✅ Predecir el CPM y la latencia de la red publicitaria a nivel de usuario para optimizar las cascadas de anuncios móviles.

✅ Capacidades de MLOps:

✅ Tienda de funciones en tiempo real

✅ Generación, control de versiones, pruebas retrospectivas y monitoreo automatizados de variantes de modelos.

MarTech

✅ Creación de un sistema de atribución multitáctil basado en modelos de aprendizaje profundo basado en modelos de aprendizaje profundo.

✅ Combinar la MTA basada en datos con el modelado de la mezcla de marketing y las pruebas de mejora para medir el verdadero aumento y la saturación incrementales del marketing.

✅ Generar escenarios de planes de gastos de marketing precisos basados en datos mediante la combinación de MMM y la previsión de la demanda.

✅ Desarrollar modelos predictivos de LTV para comprender el verdadero ROI de las campañas para la adquisición de usuarios.

✅ Comprender la saturación de las campañas y los conjuntos de anuncios y optimizar las ofertas y los presupuestos para maximizar los resultados generales.

✅ Uso de la IA generativa para generar creatividades y copias a gran escala para grandes comercios electrónicos.

✅ Optimización de los feeds de productos y la segmentación de usuarios.

✅ Predecir la propensión del usuario y la recomendación de productos.

✅ Aplicación de enfoques de IA generativa y bandidos armados múltiples para generar contenido de mensajería y entrega óptimos para Own Media.

Nuestra trayectoria

Mercado Libre

MercadoLibre es el ecosistema de comercio y pagos en línea más grande de América Latina. A través de un conjunto de soluciones tecnológicas que incluyen Mercado Pago, Anuncios de Mercado, Mercado Envíos , y Mercat Credit permiten a los clientes de 18 países llevar a cabo su comercio ofreciendo soluciones en toda la cadena de valor. Hemos tenido múltiples colaboraciones fructíferas con Mercado Libre:

- Atribución multitáctil basada en Lift: los sistemas de atribución online suelen intentar medir la contribución de cada punto de contacto publicitario (normalmente los clics en los anuncios) en los procesos de conversión. Esto implica intentar medir con precisión el aumento incremental que aporta cada punto de contacto. Nuestros equipos colaboraron para diseñar e implementar una nueva plataforma de atribución multitáctil que utiliza modelos avanzados de aprendizaje profundo para comprender el verdadero impacto a nivel de clics. El resultado: una medición en tiempo real y a nivel de campaña mucho más cercana a las estimaciones reales de impacto de cada canal.

- Sistema interno de pujas: el equipo de Product Ads (artículos buscados promocionados por vendedores de Mercadolibre) necesitaba desarrollar un sistema de pujas interno mejorado. Hemos desarrollado un nuevo sistema que permite hacer ofertas en tiempo real a medida que se realiza la búsqueda. El sistema calcula el CTR (porcentaje de clics) y el CVR (tasa de conversión) de cada artículo para determinar su posición y, al mismo tiempo, estimar el impacto en el GMV (volumen bruto de mercancías) del mercado y decidir la compensación óptima. El resultado: un aumento del 25% en los clics sin afectar al GMV orgánico.

Etermax

Etermax es una de las compañías de juegos más grandes del mundo, especialmente conocida por sus juegos de trivia encabezados por el éxito mundial Trivia Crack. Mutt Data colaboró para mejorar el rendimiento de su plataforma Demand Side frente a las plataformas móviles Demand Side más consolidadas. ¿Cuál es el resultado? Tras solo cuatro meses de trabajo, sin modificar el presupuesto utilizado anteriormente, el sistema de Etermax mostró una reducción del 40% en el coste por clic (CPC)

3 X 3 M

X3M se perfila como una empresa de tecnología publicitaria nueva y dinámica con un fuerte apoyo de la industria. Su objetivo principal es establecer un enfoque centrado en los editores en un sector que se centra principalmente en los anunciantes. Su amplia gama de servicios abarca un servicio de ADoPS totalmente gestionado, un mediador, un intercambio y varias otras ofertas. El mediador de X3M abarca un aspecto clave de sus servicios: la optimización de las cascadas. Esto representa un desafío único, ya que los editores poseen menos datos en comparación con los anunciantes y deben navegar por múltiples plataformas publicitarias con diferentes comportamientos, al mismo tiempo que se enfrentan al panorama siempre cambiante de los mecanismos de compra. Se pusieron en contacto con Mutt Data para aportar un nuevo enfoque que aprovechara la inteligencia artificial y el aprendizaje automático para lograr el siguiente gran avance. ¿El resultado? Un innovador algoritmo de optimización en cascada en tiempo real impulsado por sistemas de inteligencia artificial de última generación que permitió aumentar los CPM en un 20%.

¿Qué viene después?

La obtención de la competencia de AWS en AdTech&Martech es un gran hito para nosotros, ya que reconoce el éxito de nuestros proyectos en este campo. Junto con AWS, estamos trabajando arduamente para ofrecer las mejores soluciones del mundo de AdTech y MarTech (¡esté atento a futuros casos de éxito!). Y quién sabe, tal vez incluso una nueva competencia 😉.

Si está interesado en nuestros datos o en las soluciones de AdTech&Martech, puede contacta con nosotros aquí.

Por qué Data4Good es bueno para todos

Hacer que los datos estén disponibles para todos

Desde las compras en línea hasta la publicidad dirigida, las previsiones meteorológicas y las bibliotecas de fotos personales, nuestro mundo gira en torno a los datos. Las empresas analizan esta información a diario para optimizar las ganancias. Pero, ¿qué sucede cuando esos datos no están disponibles para quienes más los necesitan?

En el universo de las organizaciones no gubernamentales (ONG) centradas en la inclusión social y el desarrollo, el uso de datos podría significar una mejora real para la calidad de vida de las personas. Sin embargo, el acceso a estos datos y su uso suelen ser un gran obstáculo, dada la falta de recursos y la tecnología suele ser un obstáculo difícil de superar.

Aquí es donde entra en juego Mutt Data: con nuestra experiencia en análisis de datos, hemos ayudado a innumerables empresas de todos los sectores a implementar soluciones de IA modernas. No solo vemos los datos, sino que vemos posibilidades de cambio y mejora. Por eso lanzamos Mutt4Good. Una iniciativa en la que la tecnología y la empatía se alinean para apoyar a las organizaciones que realmente lo necesitan. Desde refugios de animales hasta ONG que luchan por los derechos de los niños, Mutt Data se está convirtiendo en un aliado para quienes trabajan para hacer del mundo un lugar mejor.

Iniciativas interesantes

Si bien estas iniciativas no están exentas de desafíos, como datos ruidosos, prioridades cambiantes y diversas formas de trabajar, por nombrar algunos, nos entusiasma trabajar junto a personas apasionadas que trabajan incansablemente para marcar la diferencia. Hemos aprendido a adaptarnos a diferentes metodologías de trabajo, a ser más flexibles y a adoptar la diversidad de enfoques y puntos de vista.

En Mutt Data, nuestra cultura se define por la autosuficiencia y el aprendizaje continuo. Hemos descubierto que esto es fundamental en el desarrollo de proyectos disruptivos para las empresas, así como para las ONG. Desde la creación de un banco de imágenes satelitales para analizar las comunidades hasta la implementación de modelos de aprendizaje automático para atraer donantes económicos de manera más eficiente, Mutt Data ha demostrado que los datos pueden ser una herramienta muy poderosa en las manos adecuadas.

Como Mutters, nos enorgullece participar activamente y promover un cambio positivo. Al colaborar estrechamente con las ONG, somos testigos de primera mano del impacto directo que nuestras acciones tienen en sus iniciativas. Los comentarios que hemos recibido de nuestros socios han sido abrumadoramente positivos y alentadores. Estamos más que agradecidos y honrados por la oportunidad de asociarnos con estas organizaciones.

Nuestro objetivo

El objetivo de Mutt4Good es claro: queremos que los datos y las oportunidades que ofrecen estén disponibles para quienes más los necesitan. Estamos transformando los datos en herramientas poderosas para impulsar el tan necesario cambio social. Nuestro objetivo es proporcionarles las lentes necesarias para que las ONG puedan vislumbrar un mundo de posibilidades, en el que cada dato se convierta en una oportunidad de cambio y esperanza. Porque en este viaje hacia un futuro más justo y compasivo, cada pequeño paso importa, y estamos aquí para guiar el camino.

¡Esta será la primera de una serie de publicaciones en las que exploraremos las iniciativas que Mutt está tomando para usar los datos para mejorar el mundo!

Cómo nuestro viaje anual de Mutters transforma nuestro trabajo diario

Es un eufemismo decir que es genial ver crecer a tu equipo, emprender nuevos proyectos, deleitar a nuevos clientes y capacitar a nuevos colegas. Para mí, ¡ese crecimiento nunca es tan evidente como cuando nos reunimos para celebrar nuestro viaje anual de mamá (AMT)! 💥

Nuestro evento empresarial anual se ha convertido, entre otras cosas, en un excelente momento para hacer un balance, una instantánea anual de dónde estamos y cómo hemos llegado allí.

Nuestro equipo es la razón por la que podemos emprender proyectos más grandes y seguir ayudando a las empresas a transformar sus negocios con datos y aprendizaje automático. Nuestro equipo es la razón por la que nos entusiasma empezar a trabajar por la mañana y por la que podemos mantener una actitud positiva ante los desafíos. Nuestro equipo remoto también está disperso, lo que significa que somos muy conscientes de los eventos e iniciativas que organizamos para unir al equipo.

Uno de los desafíos de trabajar en el equipo de personal de una empresa en crecimiento es cómo mantener la cultura y los valores vivos y prioritarios. Creemos que estos valores son una de las cosas que hacen de nuestro equipo un equipo único con el que trabajar.

Nuestro AMT es una de las tradiciones de Mutt Data que desempeña un papel clave en el fomento de nuestros valores. En esta publicación queremos compartir un poco sobre nuestra última aventura y sobre cómo planificamos el viaje y las actividades para conectarnos y seguir fomentando nuestra cultura única.

Haz que sea memorable 💯

Empezamos a planificar pronto. El AMT requirió más de 5 meses de preparación y participación por parte de más de 20 proveedores para garantizar que podamos ofrecer una experiencia memorable. La planificación, la presupuestación y la organización se toman en serio y se siguen de cerca como cualquier otro proyecto crítico de la empresa. Porque lo es.

Queremos que sea más grande que una típica fiesta de empresa o retiro corporativo. Planificamos cuidadosamente las presentaciones de liderazgo, los concursos de memes, las actividades de equipo e incluso los recuerdos.

Cada murmullo recibió una camiseta única con nuestro perro callejero favorito y un guiño a los famosos leones marinos de Mar del Plata. 🦭

Todos están invitados 🙋

Cuanto más crezca el equipo y se expanda a nuevas ubicaciones, ¡más tendremos que tener en cuenta en nuestra planificación! Sin embargo, al trabajar de forma remota, creemos que es importante tener la oportunidad de pasar un tiempo cara a cara con todo el mundo. Cada año es un poco más difícil, ¡pero nos encantan los buenos desafíos!

Establecer el tono

Tras el almuerzo de bienvenida, nuestro director ejecutivo, Juan Pampliega, y los directivos hablaron sobre nuestros éxitos, los desafíos que tenemos por delante y sobre cómo estamos trazando nuestro rumbo para el futuro. Si bien siempre estamos a favor de una comunicación abierta en equipo y participamos con regularidad en todos los grupos, aprovechamos esta oportunidad única para tener una conversación general.

Diferentes actividades 🤹

Terminamos el primer día con una visita a una cervecería local, dando inicio a un tiempo de calidad más informal con el equipo.

Al planificar las actividades, buscamos cosas que el equipo no hubiera hecho antes y de las que pudiera aprender, actividades que nos permitieran aprender un poco sobre el lugar local y que también permitieran que el equipo se relajara un poco para charlar.

Comenzamos el segundo día con una caminata por los acantilados con un equipo turístico local que compartió información sobre la ecología local y la preservación del medio ambiente.

Hambrientos por la caminata, compartimos un delicioso almuerzo con camarones y pasamos unas horas jugando al fútbol, al voleibol y a los tejos en la playa. ¡Nada como una competencia amistosa para unir al equipo!

Algunos decidieron continuar con la competición y se dirigieron a la pista de karts, mientras que otros optaron por relajarse en el hotel.

Terminamos el día bailando y bebiendo 💃🍹

El último día comenzó con un desayuno energizante y una presentación antes de dirigirnos a la ciudad para tomar las imprescindibles fotografías turísticas, una última comida en equipo y recuerdos.

Creemos que es importante combinar las actividades planificadas con el tiempo de inactividad para que el equipo pueda simplemente hablar y conocerse mejor. Al igual que nuestras queridas pausas para tomar café con rosquillas durante la semana, creemos que las conversaciones aleatorias durante el tiempo de inactividad pueden ayudarnos mucho a conectarnos.

Hay mucho más que puedo compartir sobre el viaje, pero espero que esta instantánea sea suficiente para mostrar un poco sobre la increíble cultura y el equipo que estamos creando. Estoy muy emocionada de añadir esta instantánea a nuestro álbum. ¡Otra postal de nuestro viaje! 📸

Si te gusta lo que has leído y crees que te gustaría formar parte de nuestro equipo, ¡buenas noticias! ¡Siempre estamos buscando personas increíbles para unirse!

Descubra la información de los datos con la IA generativa

Descubra la información de los datos con la IA generativa

Llegan nuevas herramientas a diestra y siniestra. Como probablemente sepas, la IA es la nueva palabra de moda en la ciudad. Constantemente surgen nuevas oportunidades para usar la IA en nuevas áreas. Esta es una de ellas.\ Es bastante común querer crear paneles con gráficos, estadísticas y todo lo que necesita para entender sus datos. Ya sabes: «¿Cuánto gastamos en X?» , «¿Cómo es el comportamiento estacional de nuestras ventas?» , ese tipo de cosas. Los consumidores de estos paneles suelen incluir personas sin conocimientos técnicos, como los gerentes. Solo quieren saber cómo va la empresa. Existe una desconexión entre los fabricantes de estos paneles (personal técnico) y los consumidores (personas sin conocimientos técnicos). Con los LLM podemos cerrar la brecha. Deje que los gerentes simplemente pedir preguntas y obtenga sus tramas, sus métricas o incluso nuevas preguntas interesantes para explorar.

Esa es la esencia principal. Suena genial, pero está lejos de ser perfecto. Un error común con todas las palabras de moda de la IA es no tener una canalización adecuada para poder aprovecharla.

Necesitas ordenar tus datos

Querer hacer IA está bien, pero no es tan sencillo. Tener los datos listos para el consumo es lo más importante. Las opciones que presentamos a continuación lo necesitan. No hay atajos. ¿Tienes siquiera los datos? ¿Dónde está? ¿Está en varias bases de datos? ¿Se usa con fines operacionales/transaccionales? \ Todo esto y mucho más son requisitos previos antes de que puedas pensar en añadir la IA a tus análisis. No es una tarea fácil. Necesita ingenieros de datos para configurar las canalizaciones a fin de integrar sus fuentes y realizar las transformaciones pertinentes. Ahí es donde entra en juego la pila de datos moderna.

La pila de datos moderna

Si bien cada negocio es único, hay patrones repetitivos que en realidad no cambian demasiado. Las empresas suelen utilizar los datos por dos motivos.

- En primer lugar, los datos transaccionales que se utilizan con fines operativos. Es decir, para gestionar realmente el negocio (almacenar las imágenes, guardar la información de inicio de sesión de los usuarios, los pedidos, ese tipo de cosas).

- Luego, aprovechar los datos para mejorar u obtener una mejor comprensión del negocio. Aquí encontrará sus algoritmos de visualización de datos y aprendizaje automático.

Sin embargo, por lo general, no es una buena idea que estos dos casos de uso utilicen los mismos datos directamente. Los análisis a gran escala pueden reducir el rendimiento de sus operaciones de transacción. La pila de datos moderna consiste en la colección habitual de recursos y procesos que necesita para gestionar los datos de su empresa con el fin de utilizarlos en el análisis. Es la infraestructura que necesita, sus almacenes de datos, sus transformaciones, sus visualizaciones y su flujo de trabajo.

Tenemos nuestra propia versión de la pila de datos moderna. Ya hemos hablado de ello ([1], [2]). Pero, ¿cómo encaja nuestra visualización asistida por IA en la pila de datos?

Por lo general, debe hacer que su OLAP ingiera datos de sus fuentes principales y procesarlos. El hecho de hacerlo cada x veces o de forma continua depende de la aplicación. Para nuestros propósitos, diariamente debería ser suficiente. Es una buena idea copiar algunos patrones prediseñados para esto. Una vez que tenemos los datos procesados, simplemente es cuestión de dirigirlos a la fuente adecuada. La parte más difícil es canalizar todos estos datos y encontrar la transformación adecuada

Bien, tenemos nuestra canalización de datos lista, ahora a nuestro objetivo real: hacer BI con IA

Hay diferentes opciones

Hemos comprobado un par de opciones para hacerlo. Aún tendrías que explorar tu caso de uso particular. Podemos dividirlos en 3 categorías principales. Todas las alternativas aún son nuevas, por lo que aún no son opciones maduras.

- SaaS. Al utilizar opciones prefabricadas enlatadas que existen, suelen ser más fáciles de usar y no tienes que preocuparte por su comportamiento interno. El precio varía pero, por lo general, no es barato

- Llamadas a la API: aprovechar las llamadas a LLM de terceros para hacerlo por su cuenta

- Totalmente local: haga que todo funcione en su propia infraestructura

En las siguientes secciones, ejemplificamos cada categoría y profundizamos en sus ventajas y desventajas.

AWS Q en QuickSight

AWS lanzó recientemente un nuevo servicio llamado AWS Q, que utiliza la magia del LLM para ayudar a las personas con sus preguntas sobre AWS. Todavía está en versión preliminar, por lo que es bastante nuevo. También tienen AWS Q en QuickSight, que permite a los usuarios hacer esto de la inteligencia artificial y la inteligencia empresarial. Haces preguntas en lenguaje natural y obtienes un resultado. Lo bueno de esto es que no tienes que preocuparte demasiado por cómo hacer que funcione. Es una función tipo plug and play. Es compatible con varios tipos de fuentes, tanto de AWS (como S3 o Redshift) como de sus propias bases de datos locales,

Sin embargo, es posible que las respuestas de la IA sigan siendo incorrectas. Debes tener cuidado y puedes verificar las respuestas. Además, es posible que tengas que asignar manualmente nombres descriptivos a las columnas y sinónimos para que el trabajo de LLM sea más fácil y preciso. Ahora, hablando de precio, no es particularmente barato, pero esto puede cambiar mucho con el tiempo. Tienen diferentes planes de precios pero, haciendo algunas suposiciones, según esto costaría alrededor

34 por autor al mes + 0,33 USD por sesión de lector

Los autores son los que hacen la configuración (conectan los datos, hacen los nombres descriptivos, etc.). Los lectores son tus gestores y demás. Es evidente que puede exagerarse desmesuradamente si su organización tiene muchos lectores.

Lo mejor de esta opción, creo, es que es fácil para configurar y usar. No te importa cómo funciona. Es accesible.

Usa una API de LLM

Los modelos de LLM están en todas partes ahora. ChatGPT, Cohere, Gemini, por ejemplo. Podrías intentar «hacerlo tú mismo» y hablar con un LLM usando su API. Esto tiene algunas ventajas con respecto a Quicksight. ,

- Es independiente de la nube.

- Podrías cambiar fácilmente la llamada a la API de LLM subyacente y no cambiaría nada.

Sin embargo, las herramientas para hacer su BI mediante el LLM aún no están tan maduras. Realizar las consultas, crear paneles de control y demás no es una tarea trivial. Sin embargo, esto puede cambiar con el tiempo. Pero a día de hoy, no hay un camino claro y obvio sobre cómo hacerlo.

Otro problema es la privacidad de los datos, aunque tú no necesidad para mostrar sus datos al LLM, es probable que el LLM necesite (al menos) conocer sus esquemas de datos. De lo contrario, ¿cómo podría realizar consultas?

En términos de costo, depende del proveedor de LLM, ¡pero es bastante barato! Es probable que necesites una instancia, pero el trabajo pesado se realiza mediante la API, por lo que puedes hacerte con una de nivel inferior y no habrá problema. Solo para tener una estimación aproximada , a partir de marzo de 2025, al hacernos con una instancia de AWS barata, obtenemos

0,0208 USD por hora por instancia + coste de consulta

Estimar el costo de la consulta es más difícil. ¿Cuántos tokens está utilizando? ¿Cuántas llamadas? ¿Qué modelo? Probablemente sea necesario estimarlo para el caso de uso específico.

La escalabilidad de este enfoque está limitada por la API que utilizamos. Puede alcanzar los límites de velocidad si se usa de forma masiva.

Un LLM local

De manera similar al enfoque de la API, puede eliminar la llamada a la API y hospedar el LLM usted mismo. La mayoría de las consideraciones de la sección anterior siguen siendo válidas, con algunas excepciones. En primer lugar, todos los datos nunca salen de su organización. La gran ventaja de hospedar localmente tu LLM es que puedes

- Hazte con el último modelo abierto de vanguardia disponible

- personalízalo completamente para su organización con los datos de su organización de forma privada. Esto puede mejorar la calidad de sus generaciones

Por otro lado, no es en absoluto aclara cómo hacerlo. Y definitivamente no es barato. Los buenos LLM necesitan GPUs robustas que los soporten. Solo para dar un ejemplo, usar una GPU equivale a 16 GB de VRAM (en el extremo más bajo cuando se trata de ejecutar LLM)

0,7520 USD por hora por instancia

En términos de escalabilidad, puede resultar muy caro si se dirige a una gran cantidad de usuarios. Necesitarías muchas GPU. Gestionar correctamente el escalado automático sigue siendo complicado. Requiere mucho esfuerzo y tiempo, así que hazlo y, por lo tanto, dinero. Dicho esto, siempre que solo lo usen unas pocas personas, esto no es un problema.

La discusión anterior también asume que tienes una instancia dedicada. Hay algunos servicios que ofrecen opciones de GPU sin servidor, pero eso es otro lata de lombrices. Y los arranques en frío conllevan problemas de latencia, por lo que probablemente no sea una buena alternativa.

También parece, según algunas personas que trabajan en esto, que generalmente no es necesario realizar ajustes. Basta con hacer unos pocos disparos, así que parte si los beneficios de la personalización se diluyen

Finalizando

Exploramos un par de alternativas para combinar la inteligencia empresarial con la IA. Analizamos los costos, los problemas de escalabilidad y cómo conectarlos a su pila de datos. Estas soluciones son todavía bastante nuevas. Con el tiempo, madurarán y se convertirán en alternativas realmente confiables que ayudarán a los administradores a entender sus datos. Conectarlos con su organización facilitará (con suerte) toda la experiencia para los gerentes.

Cuándo y cómo refactorizar los productos de datos

Introducción

Los productos de datos suelen evolucionar en lugar de diseñarse: son el resultado de experimentos exploratorios realizados por científicos de datos que, finalmente, conducen a un gran avance. Al igual que ocurre con los organismos evolucionados, este proceso produce estructuras vestigiales, redundancias, ineficiencias y apéndices de aspecto extraño.

Si bien este crecimiento orgánico es el resultado natural de la fase exploratoria, las presiones de selección que afectan a su producto de datos cambian repentinamente cuando se implementa en un entorno de producción. Este cambio de entorno debe ir acompañado de un rediseño para que pueda soportar grandes volúmenes de datos o, de lo contrario, se derrumbará inevitablemente.

En este artículo, exploramos cuándo (y si) es necesario refactorizar y cuáles son las mejores estrategias para abordarlos.

Síntomas

Emprender una refactorización considerable puede ser una tarea abrumadora (o incluso perder el tiempo), por lo que no se recomienda a menos que sea absolutamente necesario. Lo primero que tienes que hacer es evaluar los síntomas que está experimentando tu sistema y hacer un balance de tu estado deuda tecnológica.

Los síntomas habituales que experimenta un producto de datos son:

- Falta de visibilidad del proceso

- Dificultad para implementar nuevas funciones

- Tasa de iteración lenta del experimento

- Fuentes de datos múltiples e inconexas

- Múltiples puntos de falla irrecuperables, que producen escrituras sucias

- Resultados impredecibles, poco confiables y no replicables

- Procesamiento lento de datos

- Baja visibilidad de los datos a medida que pasan por el proceso

Algunos de estos síntomas por sí solos tienen soluciones relativamente fáciles, pero tener varios de ellos simultáneamente apunta a un problema mayor con el diseño: complejidad accidental.

Complejidad accidental es un concepto acuñado por Frederick P. Brooks, Jr.1, que se refiere a la complejidad innecesaria que acumula un software y que no ayuda a resolver el problema en cuestión.

«La complejidad se debe a la dificultad de comunicación entre los miembros del equipo, lo que provoca fallas en los productos, sobrecostos y retrasos en la programación. De la complejidad proviene la dificultad de numerar, y mucho menos de comprender, todos los estados posibles del programa, y de ahí la falta de fiabilidad. De la complejidad de las funciones proviene la dificultad de invocar esas funciones, lo que hace que los programas sean difíciles de usar. De la complejidad de la estructura proviene la dificultad de extender los programas a nuevas funciones sin crear efectos secundarios».

Esta complejidad accidental es la causa de una sensación demasiado familiar para los programadores: la incapacidad de razonar y comunicarse sobre un sistema. Impide la representación mental necesaria para conceptualizar los sistemas distribuidos y conduce a fijación en problemas más pequeños y fáciles de entender, como los detalles de implementación.

«No solo los problemas técnicos, sino también los problemas de administración provienen de la complejidad. Esta complejidad dificulta la visión general, lo que impide la integridad conceptual. Hace que sea difícil encontrar y controlar todos los cabos sueltos. Crea la enorme carga de aprendizaje y comprensión que hace que la rotación de personal sea un desastre».

Esto también crea un círculo vicioso: dado que el software es difícil de entender, los cambios se superponen en lugar de integrarse, lo que aumenta aún más la complejidad. Es necesaria una refactorización para eliminar la complejidad accidental y se debe rediseñar el sistema de forma que se minimice el aumento de la complejidad en el futuro.

Estrategia

Refactorizar un software que se mantiene activamente puede resultar complicado, por lo que recomendamos la siguiente estrategia.

Comprensión

El primer paso es realizar un análisis materialista del sistema:

¿Qué pretende hacer en comparación con lo que realmente hace?

Esta pregunta es engañosamente difícil de responder, teniendo en cuenta todo lo que hemos hablado sobre la complejidad accidental, pero si se sigue hasta el final se aclararán las contradicciones fundamentales de nuestro sistema, de las que se originan todos los demás síntomas.

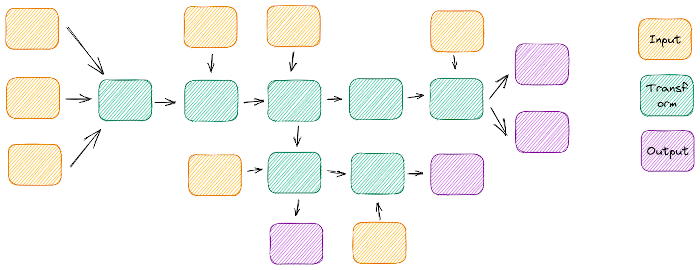

Para empezar a resolver este problema, necesitamos analizar las entradas y salidas de nuestro sistema y trabajar a partir de ahí. Es un ejercicio tedioso pero útil, que revelará los caminos que recorren los datos a través de nuestro sistema, dónde se cruzan, se enredan y cuáles nunca se encuentran.

Las entradas y salidas múltiples e inconexas tienden a significar una complejidad accidental

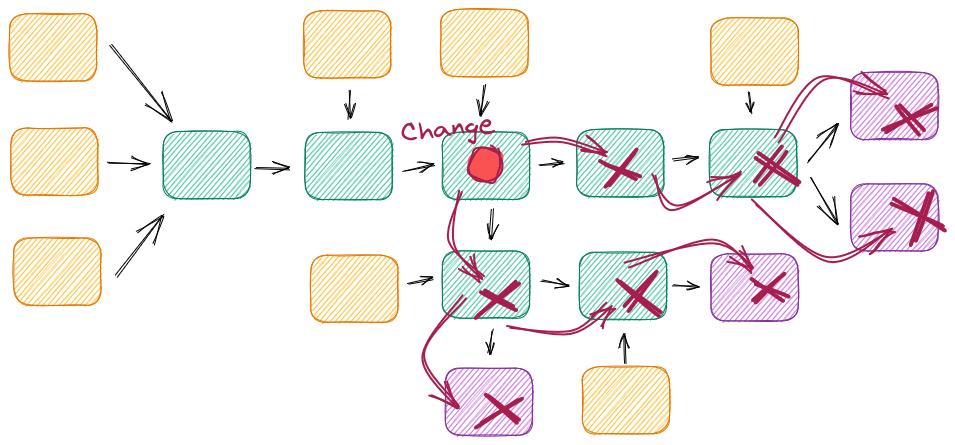

Otra buena forma de entender los entresijos del sistema y sus puntos débiles es intentar introducir un pequeño cambio en él y luchar contra los efectos dominó: ¿el cambio se limita a una sola función o clase o tiene varios efectos en el futuro? Esto es especialmente útil si no estás familiarizado con el proyecto.

Sin las interfaces adecuadas, un simple cambio puede tener efectos en cascada

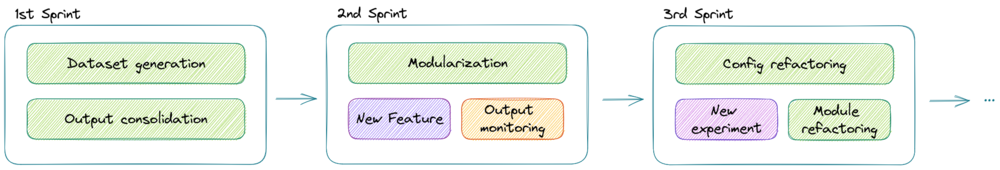

Mejoras incrementales

Tenemos que tener en cuenta que este es un sistema productivo que aún necesita mantenimiento, por lo que no podemos simplemente empezar la refactorización desde cero en un repositorio diferente y dejar que la versión anterior se pudra mientras tardamos unos meses en terminar la nueva. Por lo tanto, necesitamos elegir estratégicamente qué partes debemos refactorizar primero, en iteraciones incrementales y conservando la mayor parte del código original que podamos recuperar.

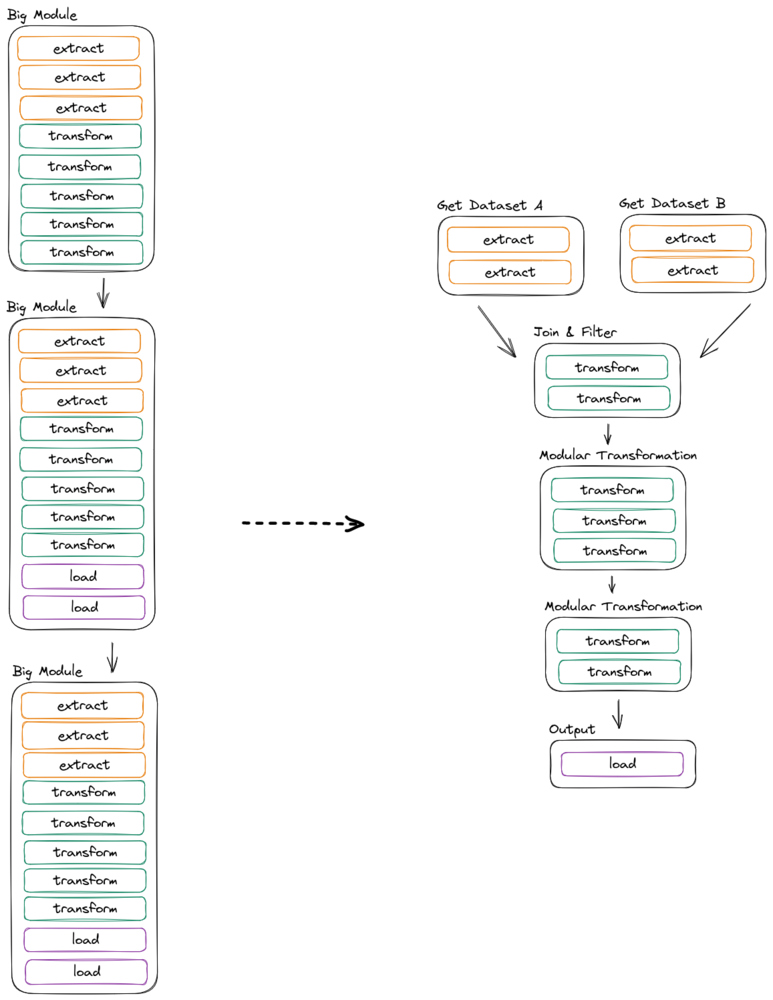

Un buen punto de partida es consolidar todas las entradas en un módulo de «creación de conjuntos de datos» y todas las diferentes salidas en una sola al final. Naturalmente, esto proporcionará puntos de inicio y final para el flujo de datos, aunque aún quede mucho trabajo por hacer a medio camino.

La refactorización incremental bien definida permite nuevos desarrollos entre mejoras

Soluciones

Ahora que tenemos un buen conocimiento del sistema y una estrategia incremental a seguir, podemos empezar a implementar nuestras soluciones.

Desenreda

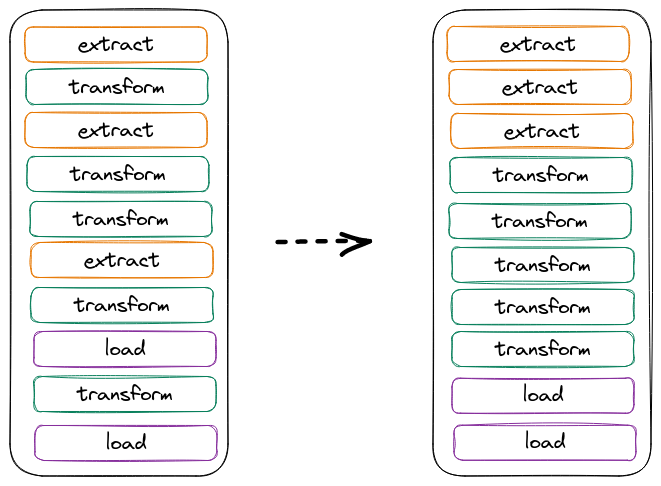

Hay una tendencia en los productos de datos a tener módulos y funciones con múltiples responsabilidades, debido al hecho de que el código exploratorio evoluciona añadiendo módulos donde se necesitan, pero sin poner énfasis en un diseño general.

En esta etapa, es útil pensar en las tres operaciones básicas de la ingeniería de datos: Extraer, transformar, cargar. El primer paso para desenredar los módulos altamente acoplados es dividirlos en estas tres operaciones básicas (y agruparlos según).

La simple reorganización del orden de las operaciones puede mejorar la comprensión

Podemos abordar este proceso con una estrategia de divide y vencerás: empezar por el nivel de función y clase y, poco a poco, ir reorganizando todo el diseño de esta manera. A medida que avancemos, empezaremos a ver oportunidades para eliminar el trabajo duplicado o inútil.

Modularizar

Ahora que nuestro código está más organizado, podemos empezar a separarlo conceptualmente en módulos. Los módulos deben seguir el principio de responsabilidad única y ser lo más claros y concisos posible con respecto al trabajo que realizan, lo que nos permitirá reutilizarlos al escalarlos.

Los productos de datos suelen crecer poco a poco en función de las exigencias de la empresa. Esto hace que los módulos estén estrechamente vinculados a la lógica empresarial, lo que los hace demasiado específicos o conllevan demasiadas responsabilidades. De cualquier manera, esto dificulta su reutilización y, en consecuencia, aumenta la complejidad accidental y reduce la escalabilidad.

Con esto en mente, deberíamos sentirnos libres de reorganizar los módulos existentes en otros nuevos y más limpios, liberándonos de las restricciones artificiales existentes en el proceso. Es probable que acabemos con clases y funciones más pequeñas que antes, y que sean más reutilizables.

Tener módulos no es necesariamente una buena modularización

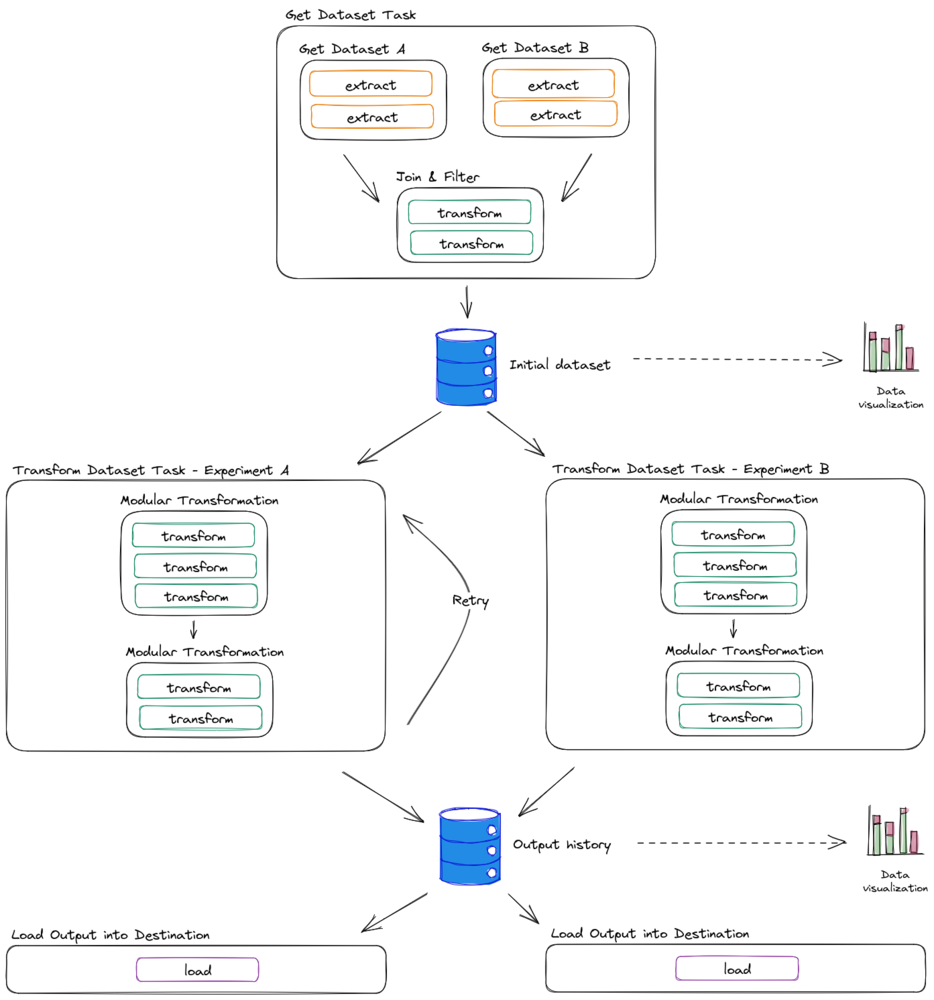

El proceso de modularización también mejorará, a través de la abstracción, la forma en que pensamos sobre nuestro código. Ahora podemos reorganizar módulos enteros sin correr riesgos e incluso es probable que descubramos que los procesos que antes estaban estrechamente relacionados se pueden separar por completo en tareas independientes.

Interfaces de diseño

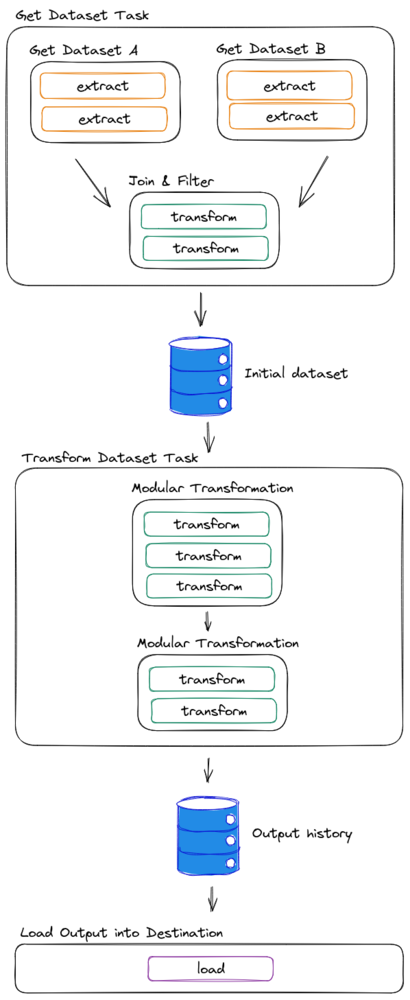

Una vez que hayamos separado conceptualmente cada módulo, podemos empezar a planificar cómo separar la canalización en tareas más pequeñas orquestadas. Para lograrlo, necesitamos definir las interfaces para cada tarea y seguirlas estrictamente.

En las canalizaciones de datos, nos gusta pensar que los datos en sí mismos son la interfaz entre las tareas, ya que siguen la estructura estricta y las restricciones que imponemos a esos datos. Teniendo esto en cuenta, solemos definir las tablas intermedias como interfaces entre tareas y los marcos de datos estructurados como interfaces entre los módulos de la tarea.

Las tareas independientes deben conservar los datos en algún lugar

Hay varios beneficios de tener tablas intermedias como interfaces sólidas:

- Aplican un esquema entre los módulos.

- Proporcionan puntos de control entre los procesamientos, en caso de que sea necesario volver a intentarlo.

- Proporcionan visibilidad en el proceso y se pueden utilizar para supervisar la calidad de los datos.

- Reducen el consumo de recursos al reutilizar los conjuntos de datos creados

- Proporcionan un conjunto de datos y un historial de resultados para reproducir experimentos o entrenar otros nuevos.

- Las tareas se pueden conectar y usar si se adhieren a la interfaz

Tener tablas como interfaces abre un gran potencial en el diseño

Optimizar

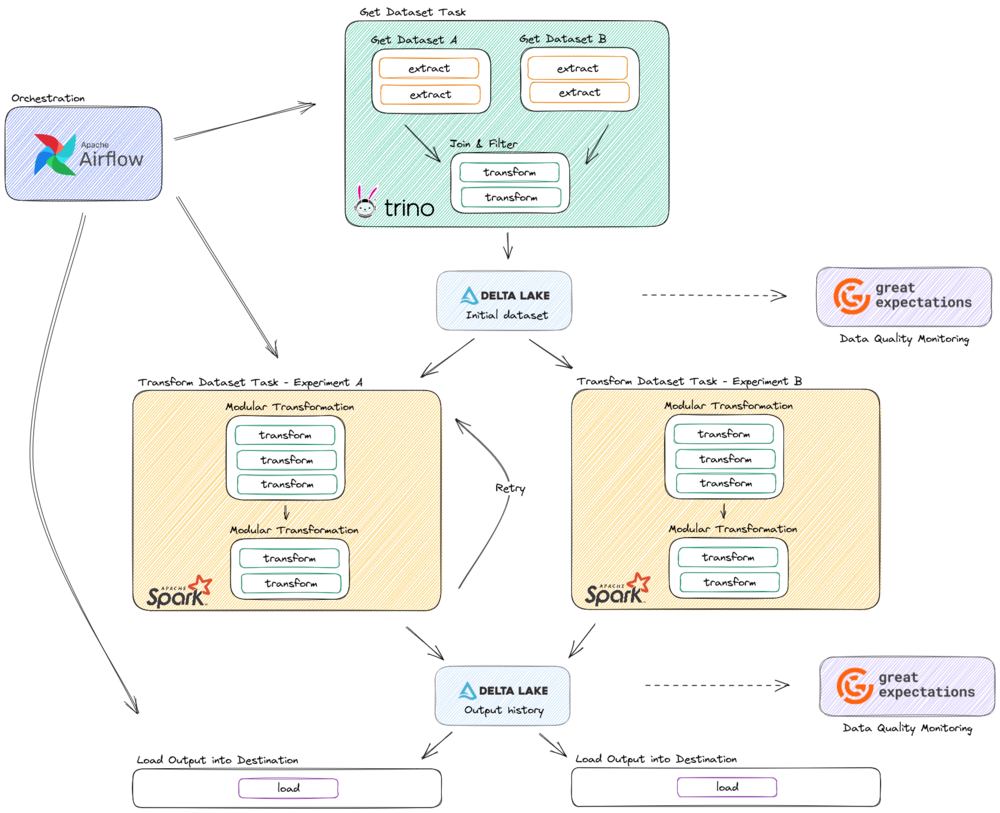

La optimización en los sistemas de Big Data rara vez proviene de obtener el máximo rendimiento de una línea de código determinada, sino más bien de evitar el trabajo duplicado, elegir las herramientas adecuadas para cada tarea y minimizar la transferencia de datos a través de la red.

Esto solo se puede lograr por completo después de aplicar las soluciones anteriores de esta lista, ya que la modularidad y la comprensión nos permitirán reorganizar el flujo de datos a nuestro favor y tener tablas como interfaces nos permitirá tener una variedad de herramientas entre las que elegir para interactuar con los datos.

Ejemplo de un diseño refactorizado que muestra diferentes tecnologías para cada tarea

Conclusiones

La refactorización de un producto de datos no es una tarea fácil, pero puede ser muy gratificante si se hace correctamente. Sin embargo, lo ideal es tener en cuenta estas consideraciones de diseño antes de implementar el MVP de Data Science en producción, ya que son más fáciles de implementar antes de esa etapa.

Notas a pie de página

- Frederick P. Brooks, Jr.»No hay fórmula mágica: esencia y accidente en la ingeniería de software« ↩

Desentrañando el laberinto del marketing

Hay tanto contenido sobre Marketing Mix Modeling (MMM) que nos llevó un minuto considerar la mejor manera de contribuir a la conversación. En esta primera publicación, nos centraremos en los problemas a los que se enfrentan los profesionales del marketing y en cuáles de estos desafíos puede ayudar MMM.

Una instantánea del panorama actual del marketing 📸

Ahogados en datos

En el panorama hipercompetitivo actual, los profesionales del marketing se enfrentan a desafíos en múltiples frentes. Con un número cada vez mayor de canales y puntos de contacto, cada vez es más difícil entender qué es lo que realmente impulsa las ventas y los ingresos. Tener más datos no se traduce instantáneamente en decisiones más fáciles basadas en datos. Levanta la mano si puedes identificarte 🙋

Hambriento de información 📈

«Según la encuesta de profesionales de marketing de HubSpot, más de nueve de cada diez profesionales del marketing utilizan más de un canal de marketing, y el 81% aprovecha más de tres canales».1 Con tantos canales en funcionamiento, no es de extrañar que los profesionales del marketing tengan dificultades para entender la avalancha de datos.

Pero no se trata solo del gran volumen de datos, sino de extraer información significativa de ellos. En la actualidad, muchos profesionales del marketing se dan cuenta de que tienen una gran cantidad de datos, pero carecen de información. Aquí es donde MMM brilla, ya que ayuda a los profesionales del marketing a identificar los verdaderos impulsores del éxito.

Los anuncios tienen efectos tanto a corto como a largo plazo, pero estos últimos pueden ser difíciles de rastrear 📈

Si bien las métricas inmediatas, como las tasas de clics y las tasas de conversión, ofrecen información valiosa sobre la respuesta inicial a un anuncio, a menudo no captan los efectos duraderos que los anuncios pueden tener a lo largo del tiempo. Los anuncios tienen efectos tanto a corto como a largo plazo, ya que influyen en la percepción de la marca, en la fidelidad de los clientes y en el valor global de la marca a largo plazo. Sin embargo, la incapacidad de medir estos efectos a largo plazo de manera eficaz puede llevar a los profesionales del marketing a pasar por alto el verdadero valor y el potencial de sus campañas publicitarias.

El marketing es multicanal, pero las métricas de medición no lo son 📺📱

Si bien la tendencia ha sido reorientar más el gasto hacia los canales digitales, los canales offline siguen siendo muy relevantes. Lamentablemente, muchos profesionales del marketing se esfuerzan por integrar y comparar los datos de rendimiento de los diferentes canales online y offline para poder planificar y pronosticar. Al no poder comparar el impacto de sus distintos canales y campañas, resulta difícil identificar el gasto óptimo para cada uno de ellos y evitar gastar de más hasta el punto de saturación.

El cuello de botella presupuestario: justificando cada dólar 💸

No es ningún secreto que cada vez hay más escrutinio sobre el gasto en marketing. Los CMO están sometidos a una enorme presión para demostrar el ROAS e identificar dónde gastar su dinero en publicidad tendrá el mayor impacto en sus objetivos comerciales. «Según el informe de Modern, impulsar los ingresos y el crecimiento a corto plazo es una de las principales prioridades de los CMO en 2024. Casi el 75% de los directores de marketing encuestados mencionaron el crecimiento comercial de las empresas a corto plazo como su prioridad más urgente para los próximos 12 a 18 meses, por encima de los objetivos a largo plazo. Este enfoque en el impacto comercial inmediato indica que los directores de marketing sienten una presión cada vez mayor por parte de los directores ejecutivos y los consejos de administración para demostrar el ROI a través de métricas como los ingresos recurrentes mensuales y los resultados de ventas trimestrales». 2

Es comprensible que, con esta creciente presión para dar sentido a la diversidad de datos de que disponen, los profesionales del marketing estén explorando las soluciones de Martech. El informe de Modern también indica que «el 37% de los directores de marketing buscan aumentar el papel de la tecnología de marketing mediante la ampliación de las soluciones, la mejora de las capacidades y la reducción de la brecha de habilidades». 2

Una de las soluciones de Martech que puede ayudar a los profesionales del marketing a abordar estos problemas es MMM.

[Actualización] El modelado de la mezcla de marketing es una técnica estadística que se utiliza para analizar y cuantificar el impacto de varias actividades de marketing en las ventas u otros resultados deseados.

Entonces... ¿cómo ayuda MMM a los especialistas en marketing a superar estos desafíos de marketing modernos?

Imagina que estás realizando varias campañas de marketing de forma simultánea, como anuncios de televisión, promociones en redes sociales, campañas de correo electrónico y anuncios en tiendas. El modelado de la combinación de marketing te ayuda a comprender cómo cada una de estas diferentes tácticas de marketing contribuye a tus ventas o ingresos generales.

Puede ayudarlo a responder preguntas como las siguientes:

- ¿Cuál es el impacto de cada canal en un KPI específico, como las ventas?

- ¿Cuáles son los efectos de marca a largo plazo de los anuncios?

- ¿Estás gastando más o menos en alguna campaña?

- ¿Cuál es la forma más eficiente de asignar su presupuesto de marketing?

Modelado de mezclas de marketing frente a otros modelos de medición

Como si la fragmentación de los canales y el aumento de la presión sobre los presupuestos no fueran suficientes, los profesionales del marketing se enfrentan a un obstáculo más en sus esfuerzos por asignar y controlar sus presupuestos de manera eficiente: la atribución sesgada.

A medida que los profesionales del marketing se enfrentan a un recorrido de cliente cada vez más complejo, los modelos de atribución tradicionales suelen ser insuficientes. La mayoría de los profesionales del marketing creen que sus datos de atribución son inexactos o están incompletos, pero se esfuerzan por establecer una fuente fiable y única de información veraz.

La mayoría de las soluciones de medición hacen que los especialistas en marketing tengan dificultades para:

- Parte inferior del sesgo del embudo: La atribución basada en reglas o en el último clic suele sobrevalorar los canales que están más cerca del final del embudo, como la búsqueda de pago, y subestima los que están en la parte superior del embudo, como la televisión.

- Las normas de privacidad restringen la atribución a nivel de usuario: Dado que Apple y Google están realizando cambios para proteger la privacidad de los usuarios, como el protocolo de transparencia en el seguimiento de aplicaciones (ATT) que se aplica con iOS14 y la desaprobación de las cookies, la atribución tradicional a nivel de usuario en los canales en línea es limitada.

- Soluciones aisladas: La mayoría de los modelos no permiten a los profesionales del marketing comparar el rendimiento de sus canales de marketing online y offline en una única visión unificada. Esta falta de una solución de medición omnicanal impide que los especialistas en marketing obtengan una comprensión integral de su eficacia general de marketing en todos los puntos de contacto.

No estamos diciendo que ejecutar MMM vaya a resolver mágicamente todos tus problemas de marketing, pero... te ayudará a eludir estas limitaciones. El modelado de la mezcla de marketing tiene en cuenta todos los puntos de contacto, tanto en línea como fuera de línea, y dado que no se basa en el usuario, no se ve afectado por las normas de privacidad.

Además, la combinación de MMM con la atribución basada en datos permitirá tener una visión holística de la contribución del marketing y ayudará a resolver el desafío de la atribución.

TL, DR: Al desentrañar las complejidades de la combinación de marketing, MMM potencia la toma de decisiones basada en datos, la optimización del presupuesto y una comprensión más clara de lo que realmente impulsa el crecimiento empresarial.

Próximamente

En próximas publicaciones, abordaremos algunas de las preguntas más frecuentes que recibimos al chatear con los especialistas en marketing, como:

- ¿MMM funciona para todas las empresas? ¿Qué tipos de empresas o industrias se benefician más del modelado de combinaciones de marketing?

- ¿Qué necesitan los anunciantes para implementar MMM en su estrategia de marketing?

- ¿Qué aspecto tiene la salida MMM? ¿Cómo pueden los profesionales del marketing aprovechar estos conocimientos?

Y muchos más. Como fanáticos de los datos, haremos todo lo posible para responder sin rodeos y sin lujos, así que estad atentos y, si tenéis alguna pregunta, ¡no dudéis en poneros en contacto con nosotros!

- Hubspot, «Principales canales de marketing para 2024 +Datos». ↩

- El CMO Club,»Las principales prioridades y desafíos de las OCM en 2024: informe». ↩↩

Generación de imágenes utilizables con IA

Introducción

Como mencionamos en nuestro post anterior, GenAI no es fiable. Además de confiar en las reglas empresariales para controlar este problema, también podemos intentar mejorar el proceso de generación en cierto sentido.

En este post presentamos un par de técnicas y trucos para mejorar/detectar problemas, específicamente para el caso de la generación de imágenes.

Desde una perspectiva empresarial, hacer que la IA generativa sea más fiable, como ya se ha mencionado, nos permite tomar diferentes caminos: optar por no participar, reducir la participación humana, etc. Además, desbloquea algunas aplicaciones que no serían posibles con modelos menos fiables, como la automatización.

Para comenzar con nuestra revisión del proceso de generación de imágenes, empecemos con la configuración más simple: una máquina ejecuta un modelo y genera imágenes.

Dada esta sencilla configuración, nuestras opciones son bastante limitadas. Podemos hacer lo mismo mejorar la fiabilidad del modelo o podemos seleccionar y ajustar las imágenes ya generadas. En las siguientes secciones presentamos algunos enfoques que abordan estos dos aspectos.

Advertencia: el futuro se acerca rápidamente

Antes de presentar estos trucos, debemos abordar el problema. El futuro está llegando... ¡y se acerca rápido! Prevalece la tendencia de que están surgiendo modelos más grandes y mejores a diestra y siniestra. La evidencia indica que los modelos más grandes pueden superar los problemas y las limitaciones que antes se encontraban en los modelos más pequeños.

Comparación de los resultados de modelos con diferentes números de parámetros.

Por lo tanto, dado que el panorama cambia constantemente, tenga esto en cuenta: además de los consejos que compartiremos más adelante, la clave es pensar de forma creativa, mantenerse actualizado y aportar valor a la próxima versión importante del modelo.

Consejo 1: Utilice modelos ajustados en lugar de modelos convencionales

Si quieres crear imágenes para un propósito específico, normalmente es es mejor usar un modelo que se haya ajustado para una tarea similar en lugar del modelo original.

Hay varios modelos preentrenados disponibles en línea para diferentes propósitos, como retratos o realismo. Es una buena idea empezar con uno de estos si tu tarea está estrechamente relacionada con esas áreas, ya que es probable que proporcione resultados de mayor calidad.

Si tiene los recursos, también puede afinar uno usted mismo. ¿Qué es mejor que un modelo adaptado a tus necesidades? Hay muchos recursos sobre cómo hacerlo, por ejemplo, esto documento de entrenamiento de Hugging Face o esto guía para principiantes de OctoML.

Consejo 2: Utilice LoRas para realizar ajustes precisos cuando los conjuntos de datos son pequeños

Hemos establecido que el ajuste fino es una alternativa eficaz cuando se trata de generar imágenes para un problema específico. Pero, ¿qué pasa si tu conjunto de datos es muy pequeño? No te preocupes, puedes usar Adaptación de rango bajo.

Es más económico que un ajuste completo, lleva menos tiempo y se puede realizar con conjuntos de datos muy pequeños (rango ≈ 10-200).

También es ideal para «enseñar» conceptos específicos a los modelos, guiando a la generación hacia un ámbito más estrecho y predecible. Si no estás seguro de por dónde empezar, Hugging Face tiene una gran guía con guiones para entrenar tu LoRa para que puedas conectarlo y usarlo.

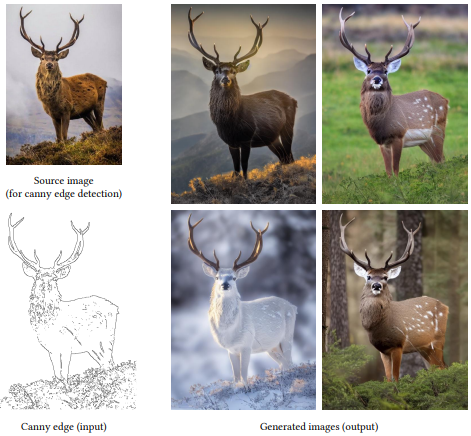

Consejo 3: Utilice modelos de conversión de texto a imagen entrenados para tareas específicas para controlar sus resultados

¿Qué queremos decir con controlar sus salidas? Bueno, pasemos a un ejemplo empresarial, digamos que necesitas diseñar un anuncio en el que un logotipo o un elemento debe estar en un lugar específico o necesitas que un personaje esté en una pose específica. Básicamente, una imagen que se adhiere a una estructura o composición específica.

Hay excelentes modelos de conversión de texto a imagen que te permiten controlar estas variables y están entrenados para diferentes tareas específicas (incluso puedes entrenar las tuyas propias, pero... necesitas conjuntos de datos muy grandes).

Algunos modelos a tener en cuenta: ControlNet, Adaptador T2I, y Gligen.

Tenga en cuenta que, si bien estos trucos le dan control sobre la salida, podrían reducir la calidad de los resultados, en otras palabras, las imágenes pueden quedar mal. (de nuevo, depende del modelo de texto a imagen subyacente, entre otros factores).

Consejo 4: Considera en qué nos enfocamos en una imagen

Si bien no se usa estrictamente para mejorar las imágenes generadas, los mapas de prominencia proporcionan una herramienta poderosa para evaluar la atención prestada a los diferentes elementos de una imagen. Esto resulta beneficioso de varias maneras: al comprender dónde se centran las personas, puede asignar una importancia variable a los errores en las muestras, identificar las regiones óptimas para incorporar elementos o decidir la dirección de cultivo más adecuada.

Consejo 5: Puntuación y filtro

Por último, pero no por ello menos importante, uno de los métodos más útiles que encontramos fue puntúa las imágenes generadas y clasifica los tipos de error. De esta forma, podríamos abordar cada tipo de error por separado, dividiendo y conquistando, aumentando el porcentaje de imágenes aceptables, identificando patrones y, posteriormente, filtrando las que consideráramos inadecuadas.

La forma más fácil y eficaz que encontramos para implementar este enfoque fue crear heurísticas simples. Examinamos varios casos de fallos y determinamos si existía la posibilidad de eliminar los problemas más críticos.

A continuación, ofrecemos algunos ejemplos de heurísticas de diferentes casos de uso.

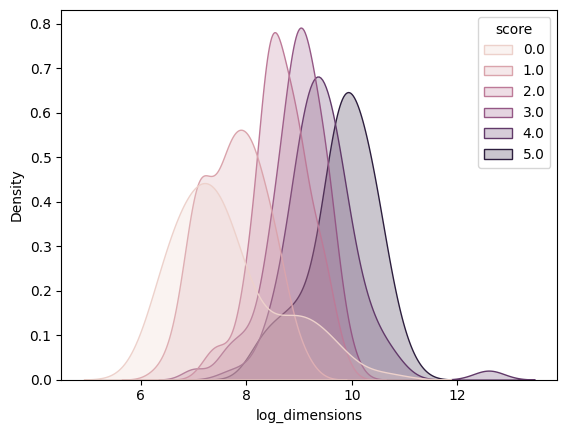

Heurística 1: Al generar imágenes con personas, las caras pequeñas tienden a quedar mal

Evaluamos manualmente unos 600 rostros y descubrimos un patrón claro: las caras tienden a tener más errores cuando están en un área pequeña. Por lo tanto, filtrar imágenes que contienen rostros pequeños resulta ser una estrategia convincente.

Gráfico de densidad que muestra la calidad de generación de rostros (de 1 a 5) en comparación con el tamaño (en logaritmos del tamaño de los píxeles), con puntuaciones más altas para las dimensiones más grandes.

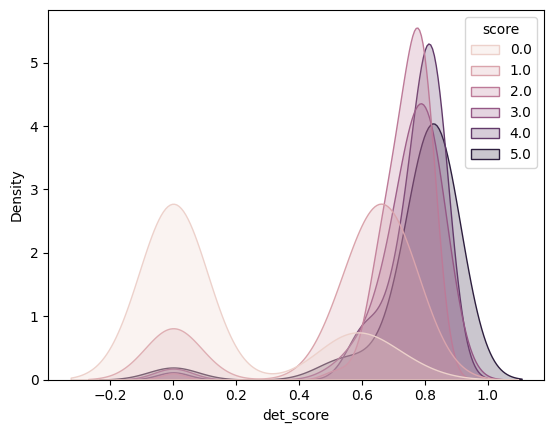

Heurística 2: Al generar imágenes con personas, los modelos de detectores de rostros son un buen indicador

También descubrimos que la puntuación de un detector facial estándar puede servir como una métrica sencilla para filtrar imágenes incorrectas. Los detectores de rostros automáticos parecen tener menos confianza en que el resultado sea un rostro cuando el rostro generado tiene problemas. Por lo tanto, naturalmente, podemos aprovechar un modelo de detector facial listo para usar para mantener las puntuaciones por encima de un umbral adecuado (según su caso de uso específico). A continuación, se muestra un gráfico en el que se compara la distribución de confianza de los detectores para diferentes imágenes etiquetadas manualmente según una puntuación humana.

Por lo tanto, los peores infractores pueden ser descartados fácilmente con esta técnica. En el caso de las imágenes con puntuaciones más altas, las distribuciones son demasiado cercanas, por lo que es posible que esto no funcione con muestras «casi correctas».

Heurística 3: Cuando pintes para generar personas, simplemente comprueba los píxeles de la piel

¿Dónde está la cabeza? En un caso de uso específico, tuvimos que actuar como pintores para completar una imagen de camisa con un ser humano. Sin embargo, pronto descubrimos que algunas muestras tenían un problema evidente...

¡A veces, las muestras generadas no tenían cabeza ni brazos! Implementamos la heurística más simple que se nos ocurrió. Solo tienes que comprobar si hay suficientes píxeles del color de la piel en la región. Si hay más de un umbral deseado, supongamos que es una cabeza/brazo. Este truco tan simple logró eliminar una buena cantidad de muestras incorrectas.

Heurística 4: Sondeo de imágenes en busca de semánticas extrañas con modelos multimodales

Una imagen generada puede ser errónea por varias razones. Un problema común es la representación de imposibilidades: anormalidades faciales u objetos que se fusionan a la perfección entre sí. Pero las imágenes también pueden ser erróneas porque no se ajustan a nuestros principios humanos ni a nuestra comprensión del mundo. Para ilustrarlo, considera la siguiente imagen:

Todo lo que pasa en esta imagen es físicamente posible, pero inmediatamente nos sorprende el hecho de que el hombre le apunte con el taladro a la cara, algo que no debes hacer. Pero, ¿cómo lo sabe esa IA?

Los modelos multimodales ofrecen un enfoque prometedor para abordar este problema: conectar imágenes y texto. Por ejemplo, los modelos Blip, si bien requieren mucho hardware, podrían resolver este problema. Lo intentamos, pero no logramos resultados útiles, ni siquiera a la hora de plantear la pregunta.

Modelo: PromptResultblip2-opt-6.7bPregunta: ¿Por qué es peculiar esta imagen? Respuesta: El hombre sostiene un taladro. Pregunta: ¿Hacia dónde apunta el hombre con el taladro? Respuesta: El hombre apunta con el taladro a la pared. Pregunta: ¿El hombre está haciendo algo gracioso? Respuesta: No, está trabajando en un taladro. Pregunta: ¿El hombre se apunta con el taladro a la cara? Respuesta: No, el hombre apunta con el taladro a la pared.instructblip-flan-t5-xlPregunta: ¿Por qué es peculiar esta imagen? Respuesta: La imagen es peculiar porque el hombre lleva un casco. La imagen es extraña porque el hombre está haciendo algo mal. ¿Por qué? La imagen es extraña porque el hombre sostiene el taladro de manera incorrecta. Describa la imagen con todo detalle La imagen muestra a un hombre con un casco y sujetando un taladro. Lleva puesto un casco de seguridad y sonríe, lo que sugiere felicidad. Es probable que el taladro sea una herramienta utilizada en la industria de la construcción.blip2_vicuna7b_instruct¿Qué tiene de inusual esta imagen? La imagen muestra a un hombre con un casco que sostiene un taladro eléctrico. Esto sugiere que está trabajando en un entorno potencialmente peligroso, como una fábrica o una obra en construcción. El casco es un equipo de protección individual (EPP) para prevenir lesiones en la cabeza y el taladro es para tareas de construcción. ¿Qué tiene de divertido esta imagen? El humor radica en que el hombre lleva un casco mientras sostiene un taladro eléctrico y sonríe, creando una escena desenfadada. ¿Qué pasa con el hombre que sostiene el taladro? No hay ningún indicio claro de que haya algo malo en el hombre o en su situación. Parece estar usando el taladro como parte de su trabajo o tarea.

Heurística 5: Puntuación automática

Aunque dos imágenes sean válidas, es posible que una sea mejor que la otra. ¿Por qué? Bueno, los resultados dependerán en última instancia del objetivo de la imagen. Por ejemplo, algunos anuncios funcionan mejor que otros para generar conversiones. Este fenómeno es difícil de cuantificar porque las preferencias son difíciles de cuantificar. Preguntar a los expertos no sería práctico a gran escala; en cambio, una métrica automática podría hacer el trabajo.

Hemos encontrado Puntuación de selección (referencias: 12) para ser una métrica automatizada útil para este propósito. Pickscore es un modelo de IA que predice la preferencia que un humano tendría por una imagen sobre otra en los aspectos más generales posibles. De esta forma, podemos usar el Pickscore para calificar las imágenes generadas según su calidad y seleccionar las mejores. Según nuestra experiencia, ayuda a identificar las imágenes que se desvían del mensaje original y a elegir aquellas más agradables desde el punto de vista estético.

Descargo de responsabilidad: es posible que Pickscore, que se basa en que a las personas les gusten las imágenes, no se alinee con tus objetivos. Mide la estética, no las preferencias de los expertos. Funcionó para nosotros, pero su utilidad depende de su problema. Ajustar sus datos es una opción, pero necesita un conjunto de datos de tamaño considerable, lo que puede ser un desafío.

Conclusión

En conclusión, este artículo ofrece información valiosa para abordar los desafíos que plantea una IA generativa poco fiable, centrándose específicamente en la generación de imágenes. La conclusión clave es la necesidad de que las empresas adopten estrategias que mejoren la confiabilidad de los modelos de IA.

Los consejos presentados ofrecen enfoques prácticos para mejorar los procesos de generación de imágenes. En primer lugar, utilizar modelos ajustados y adaptados a tareas específicas (Consejo 1) y empleando la adaptación de bajo rango para conjuntos de datos pequeños (Consejo 2) se hace referencia a ellos como métodos eficaces. Además, sugerimos utilizar modelos de conversión de texto a imagen para un control preciso de las salidas (Consejo 3) y haciendo hincapié en las regiones más relevantes dentro de las imágenes generadas mediante el uso de mapas de prominencia (Consejo 4).

Por último, pero no por ello menos importante, El consejo 5 destaca un mecanismo de puntuación y filtrado para abordar varios tipos de error. La heurística proporcionada, como el análisis del tamaño de los rostros y el aprovechamiento de los modelos de detectores de rostros, ofrecen formas prácticas de mejorar la calidad general de las imágenes generadas con esta técnica. Reconociendo la ausencia de una fórmula mágica en la IA generativa, recomendamos encarecidamente mantener un enfoque creativo y heurístico adaptado a casos de uso específicos. Dada la naturaleza dinámica del campo y la aparición continua de modelos mejores y más grandes, mantenerse actualizado y pensar de forma creativa es esencial para aportar valor a las futuras versiones de los modelos.

Aprovechar la potencia de la generación de inteligencia artificial para crear sistemas de producción robustos

Introducción

A estas alturas, probablemente hayas notado un gran revuelo en torno a GenAI. Puede parecer que las posibilidades son infinitas, y es porque lo son. GenAI está allanando el camino para una amplia gama de aplicaciones.

No por nada nos llamamos #DataNerds, por eso durante el último año nos hemos estado haciendo nerds y experimentando con diferentes aspectos de GenAI, cada uno de los cuales ha tenido diferentes niveles de éxito.

¿Nuestra principal conclusión? La mayoría de las capacidades de GenAI no se pueden emplear fácilmente en aplicaciones únicas orientadas al cliente o listas para la producción. Sus resultados aún no están listos; pueden ser impredecibles, propensos a errores, arrojar resultados no válidos o no cumplir con precisión los criterios deseados.

¡Pero no te preocupes! Hay una serie de estrategias para producir resultados valiosos listos para los entornos de producción.

Así que la generación de IA no es perfecta (todavía): ¿qué podemos hacer al respecto?

Imagine una aplicación en la que el modelo debe producir resultados a escala: imágenes, resúmenes de documentos y respuestas a las preguntas de los clientes a través de la interfaz de usuario de un chatbot. Se puede suponer con seguridad que, independientemente de lo que hagamos, algunas muestras no se podrán utilizar para el objetivo previsto.

Entonces, ¿es impresionante? ¿Y qué podemos hacer al respecto?

Bueno, depende, especialmente del impacto de la salida defectuosa inadvertida. Cuanto mayor sea el impacto del error, mayor será nuestro esfuerzo por reducir su frecuencia.

He aquí un ejemplo: si utilizamos un bot para las relaciones públicas en las redes sociales, un «error con un bot» podría afectar gravemente a la reputación de la empresa. Por lo tanto, en este contexto, se podría considerar la posibilidad de incorporar comprobaciones adicionales realizadas por humanos o por otros medios para alcanzar el nivel de error deseado. ¿Cuál es el inconveniente? Este enfoque implicaría un aumento de los costes.

Entonces, ¿es impresionante? Para garantizar que una aplicación sea viable, tanto la frecuencia de los errores como los costes asociados deben estar dentro de un límite razonable.

Decodificando el éxito de GenAI: definición de las tasas de aceptación óptimas

Genial, por lo que la frecuencia de los errores y los costos asociados deberían estar dentro de un límite. ¿Cómo definimos ese límite? ¿Cuáles son nuestros criterios de aceptación? Como ocurre con cualquier otro problema de ingeniería, el primer paso es entender cómo debería ser la solución.

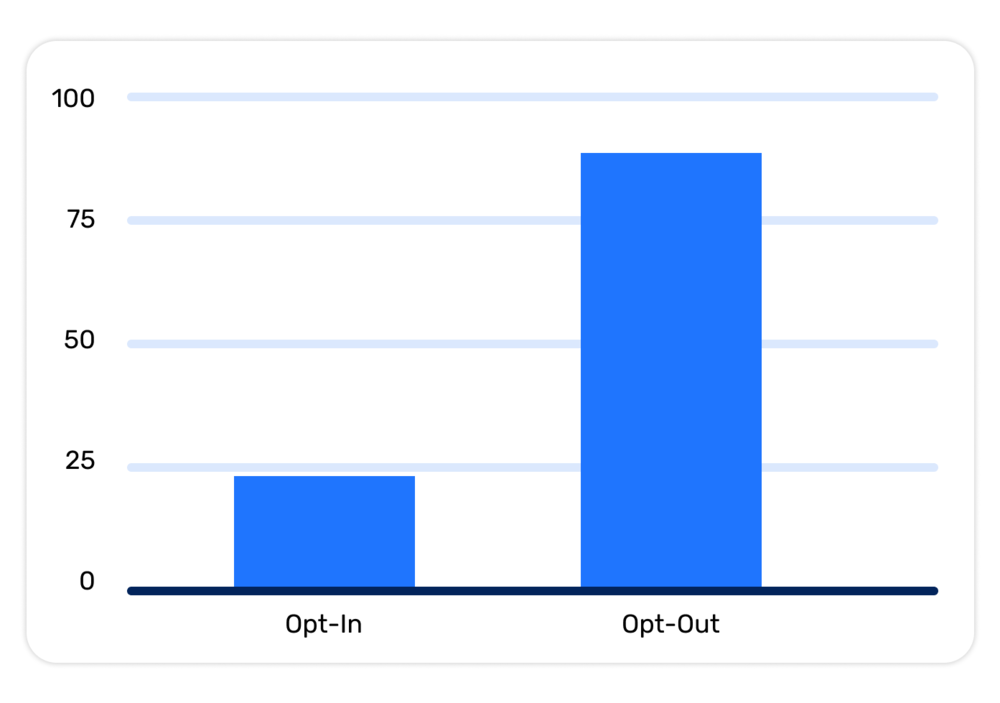

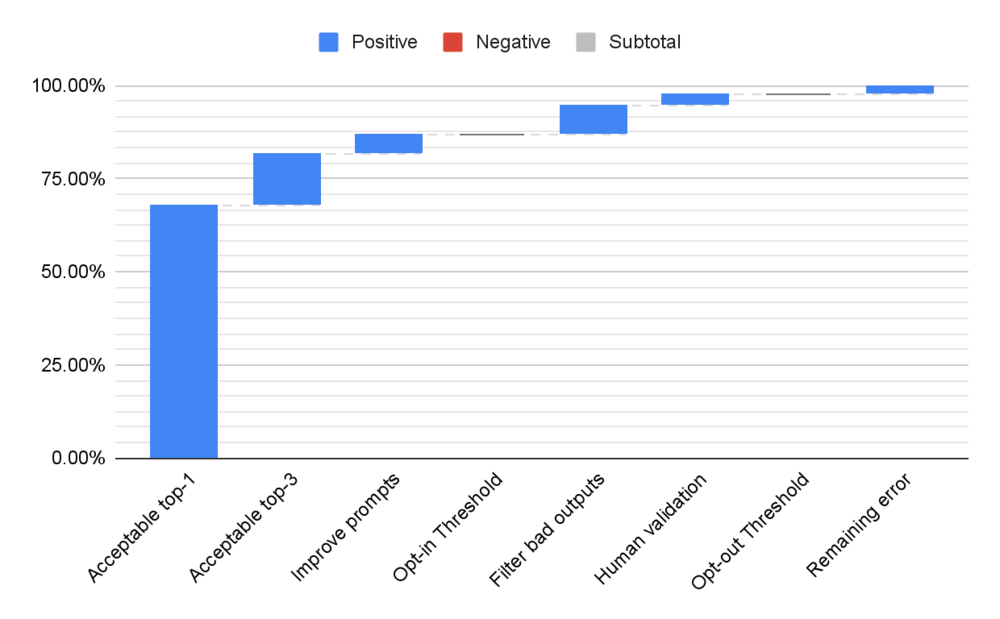

Nuestra solución consiste en entender la tasa de aceptación de los resultados del sistema como un proceso continuo que permite diferentes casos de uso. Cuando se trata de implementar funciones basadas en Genai, identificamos dos umbrales distintos de tasas de aceptación:

- Suscribirse: Esta es la tasa de aceptación mínima requerida para abrir la función a los usuarios, lo que les permite aceptarla o rechazarla. Si la tasa de aceptación cae por debajo de este umbral, los resultados pueden considerarse inutilizables.

- Exclusión: En este nivel, el número de resultados erróneos es lo suficientemente bajo como para que la función esté habilitada de forma predeterminada, y los usuarios que no deseen utilizarla deben deshabilitarla de forma proactiva.

Tenga en cuenta que lo que constituye un resultado válido depende en gran medida de la aplicación y la UX que se diseñen. En algunos casos reelaborar el problema inicial junto con el cliente puede ser la clave para descubrir soluciones exitosas.

El marco de aceptación y exclusión voluntaria en acción

Veamos cómo sería realmente la implementación de un marco de aceptación o exclusión voluntaria para encontrar soluciones viables dentro de un contexto de diseño empresarial y de funciones. Ten en cuenta que los pasos que se enumeran son ejemplos y pueden variar en función de los casos individuales.

Imagine un sistema de IA de generación que se utiliza para generar descripciones de productos para un sitio web. En este caso, estableceremos el umbral de aceptación en el 85% para los casos de suscripción voluntaria y del 98% para los casos de exclusión voluntaria.

Repasemos los pasos para llegar al umbral de suscripción: 1. Como punto de partida, consideramos solo un texto de salida y lo consideramos aceptable solo para el 68% de los productos de entrada. 2. Observamos que si adaptamos la experiencia de usuario para que el usuario pueda seleccionar una de las 3 imágenes, la tasa de aceptación mejora un 14%. 3. Gracias a nuestro rápido proceso de ingeniería, conseguimos un aumento adicional del 5%, lo que nos sitúa por encima del umbral de aceptación.

Ahora, el umbral de exclusión: 1. Podemos identificar los resultados incorrectos, filtrarlos y sustituirlos tomando muestras de otros nuevos del proceso generativo. Supongamos que esto produciría una mejora del 8%. 2. En este punto, si nos quedamos sin mejoras, el último porcentaje necesario para alcanzar el nivel de exclusión podría consistir en añadir un filtro de moderación humana al proceso. Tenga en cuenta que es posible que esto no sea factible en muchas aplicaciones.

La validación humana: evaluación cuantitativa de costos y beneficios

Para algunas aplicaciones, en las que las muestras «reales» también se someten a moderación (como las imágenes de un sitio web), la validación humana ya forma parte de los procesos existentes. Sin embargo, existe un equilibrio entre el coste de detectar esos errores y el coste de hacer que personas reales comprueben cada envío.

En términos más cuantitativos, podemos pensar en un modelo simplificado para el ingreso neto por unidad basado en las siguientes variables:

- Cg: Costo de generar un producto.

- Ch: El costo de que una persona valide el resultado mencionado.

- Ce: coste medio de un error, independientemente de que una persona lo haya omitido o no.

- Pg: Posibilidades de que el sistema genere una salida errónea.

- Ph: Posibilidades de que el sistema genere un resultado erróneo que luego haya sido validado por una persona.

- R: Ingresos promedio generados por tener un producto correcto.

Ahora vamos a definir el ingreso neto:

$$Ingresos netos = Ingresos totales - Costo total$$

En el caso de un sistema de extremo a extremo sin intervención humana, tenemos:

$$Ingresos totales = R * (1 - Pág) $$

$$Coste total = Cg + Ce * Pg$$

$$Ingresos netos = R - Cg - Pg * (Ce - R) $$

Con la intervención humana tenemos:

$$Ingresos totales = R * (1 - Ph) $$

$$Coste total = Cg + Ch + Ce * Ph$$

$$Ingresos netos = R - Cg - Ch - Ph * (Ce - R) $$